-

@ThothChildren

@ThothChildren

- 2017.9.13

- PV 411

活性化関数とは

ー 概要 ー

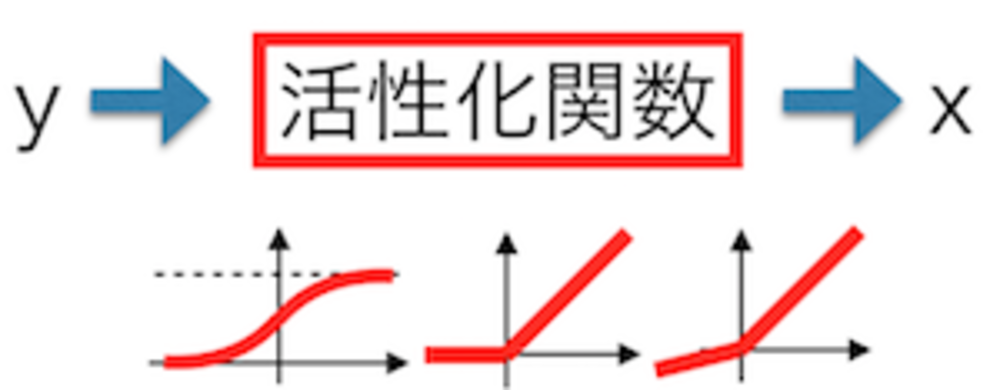

Deep Learningで層の出力の際に必ず使われる活性化関数。

活性化関数は、そのニューロンの出力を補正してやる役割があり、発散等を防いでいます。これらはネットワークの表現力を高くするために常に非線形関数が用いられます.

この章を学ぶ前に必要な知識

効果

- ニューラルネットワークでは欠かせない各ユニットの出力を補正する

- 勾配が発散することや消滅することを防ぐ役割を持つものが近年採用される

ポイント

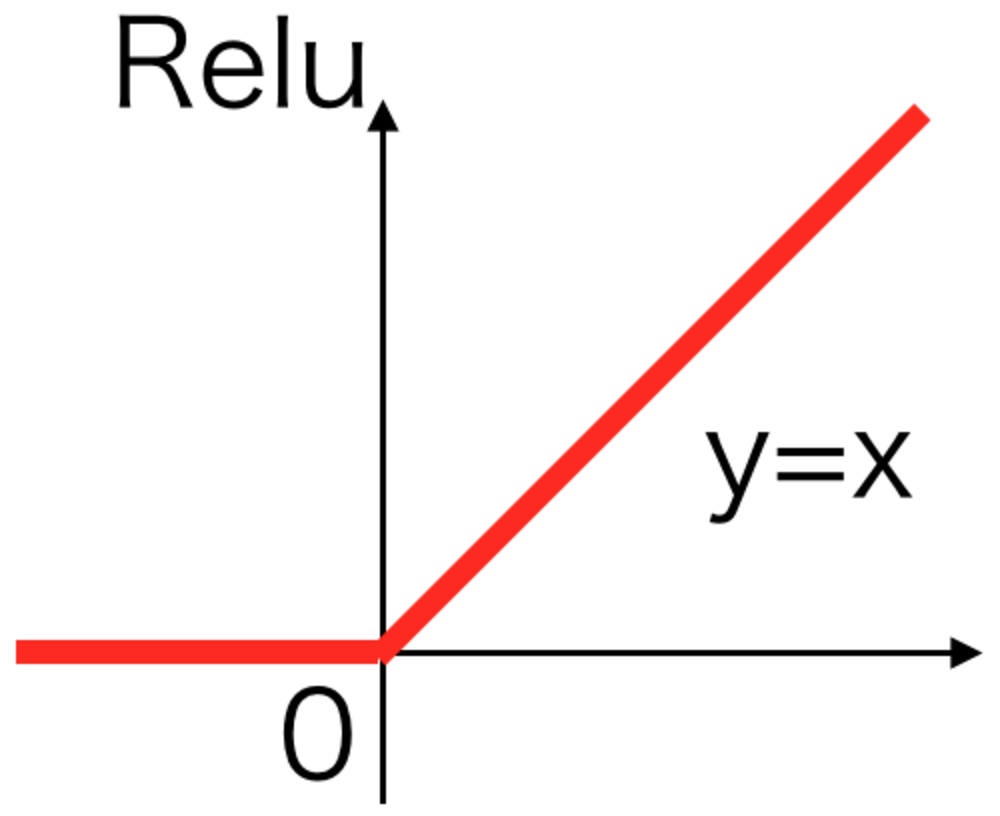

- 近年はReluが頻繁に使用される

- Reluでもダメな時は他のLeakyReluやPReluを試す

解 説

活性化関数ではニューラルネットワークのニューロンが積算値を計算した値に、

その値を入力に非線形な関数を通して値を変換する関数である。

この活性化関数を利用することでニューロンの値を非線形にして表現力をあげたり、

あまりに大きすぎる値にすることを防いだり、出力をできるかぎり0にしたりして

学習させやく学習精度を向上させる役割等をさせることができます。

活性化関数は様々な種類があり、それぞれの特徴も異なります。

近年学習精度が高いとされ頻繁に使用されるのはRelu活性化関数です。 | 活性化関数とは |

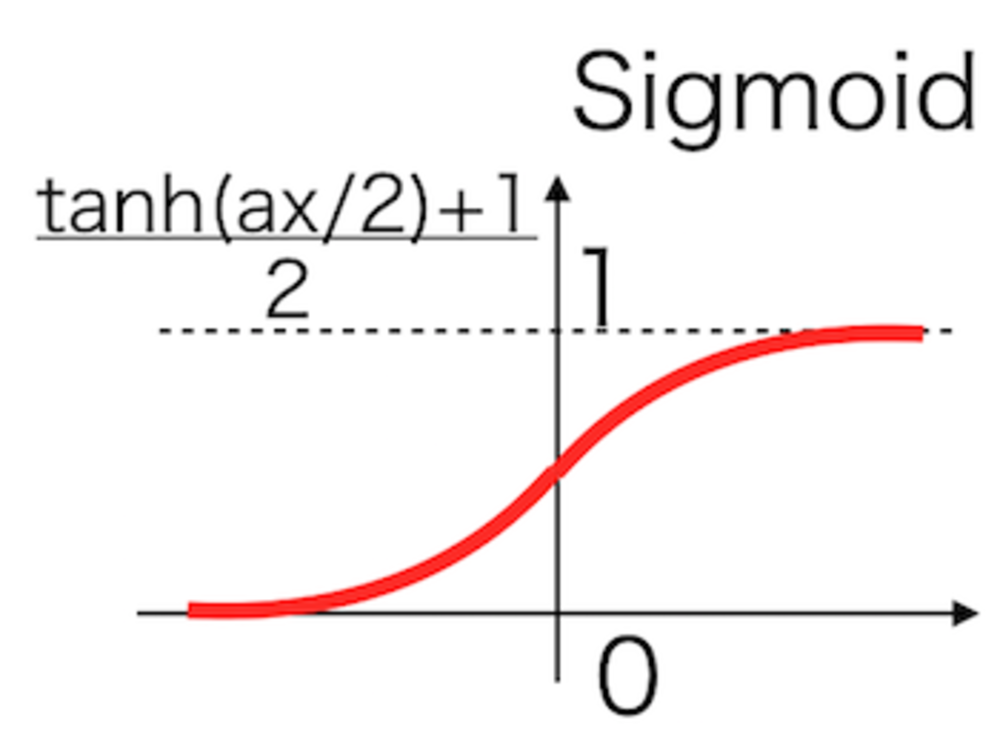

DeepLearningでは使用されないが長い間使用されていた活性化関数としてSigmoid活性化関数があります。近年この関数による勾配消失が問題となり使われません。 | Sigmoid活性化関数 |

Sigmoidに変わって使用されるようになった活性化関数です。

上記の勾配消失問題を解決し今多くのニューラルネットワークで使用されています。 | Relu活性化関数 |

この章を学んで新たに学べる

Comments

Reasons

知識: Sigmoid活性化関数

1990年代まで最も長らく使われていたニューラルネットの活性化関数.

人間のニューロンの入出力にヒントを得て設計され、微分も用意なため重宝されてきたが、勾配消失問題の原因になっているため、現在では使われない.