-

@ThothChildren

@ThothChildren

- 2017.9.13

- PV 383

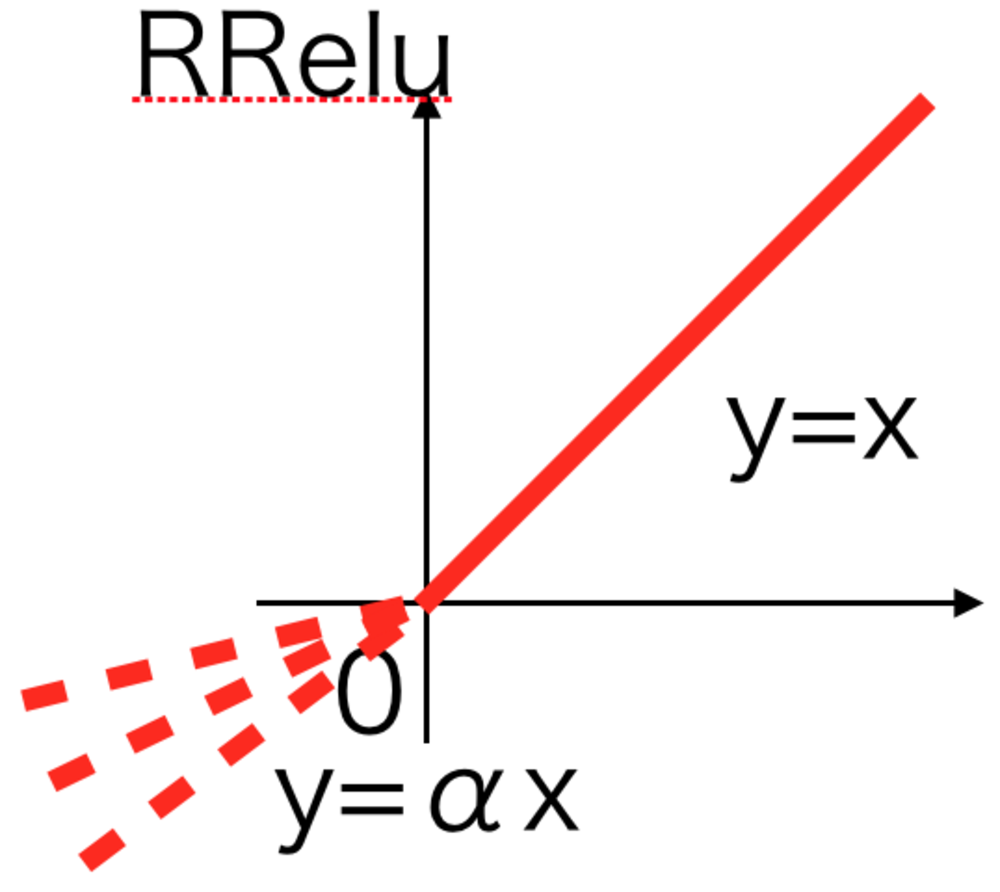

RRelu活性化関数

ー 概要 ー

PReluでは傾きを学習していたが、RReluではある幅の中で傾きをランダムにしている.

Randomized Leaky Relu活性化関数と呼ばれる.

この章を学ぶ前に必要な知識

効果

- 学習精度が上がると言われている

ポイント

- あまりメジャーなRelu系活性化関数ではない

解 説

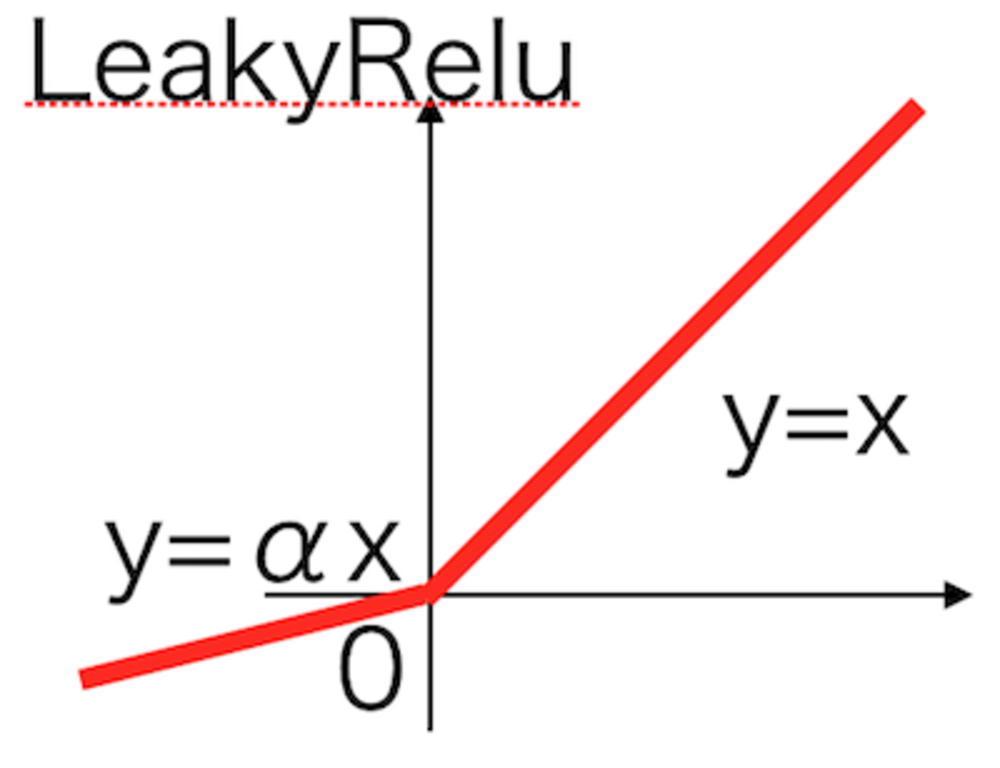

Leaky Relu活性化関数において負の傾きをランダムな値にした活性化関数. | LeakyRelu活性化関数 |

RReluの元論文へのリンクを貼っておく | 外部リンク 元論文 |

この章を学んで新たに学べる

Comments