-

@ThothChildren

@ThothChildren

- 2017.9.13

- PV 611

ResNetとは

ー 概要 ー

ResNetは2015年にMicrosoftより発表された152層からなるニューラルネットワーク.

今まで20層ほどで作られていたCNNを特別なユニットを挟むことで深くすることを可能にした.

この章を学ぶ前に必要な知識

効果

- 層を深くし、識別能力をあげた

- ImageNetにおいて3.57%のエラー率

ポイント

- ショートカットの道を用意した基本ユニットをベースとしてつなげることで深くすることを可能にした

- 層への入力と層の出力の差分を学習させている

- 最大1202層までつなぐことができエラー率も改善していく

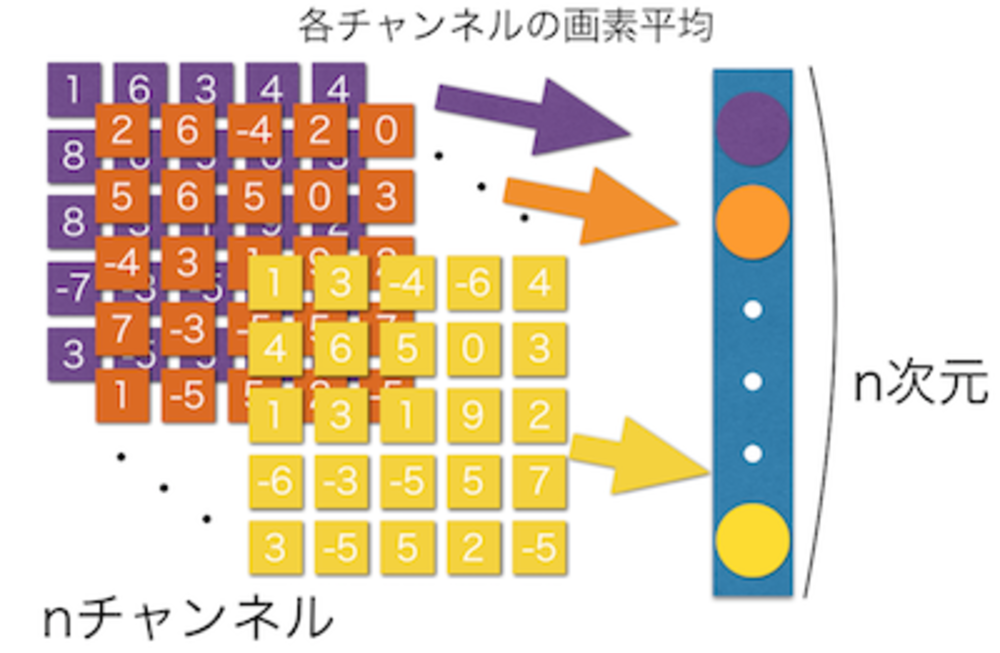

- ResNetは出力にGlobal Average Poolingを使用

解 説

ResNetは2015年のILSVRC 2015 にて優勝したネットワーク.

152層もの深さを実現してImageNetで3.57%という今までにない精度を実現している. | ResNet導入 |

Deep Learningでは経験的に層を深くすると良い性能を出すとされていたが、なかなか深くすることができていなかった.

深くするにつれて一部の層が学習時に更新をしなくなってしまうからである。

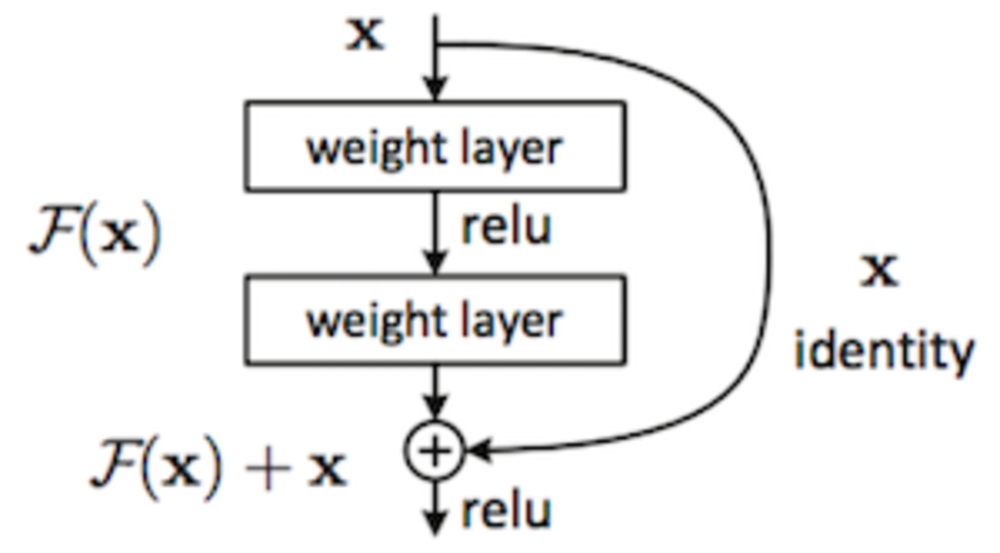

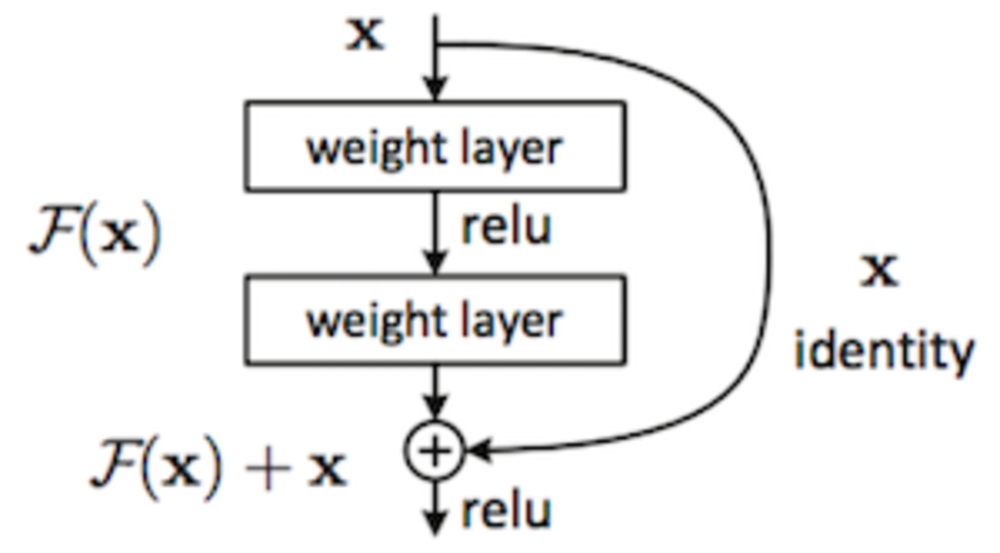

ResNetは層を直列につなげただけではなくそれぞれで、層の入力から出力へ結びそのまま入力の値を流し込むルートを用意した。

そのパスがあることで学習を促される層は入力からどれだけ違うかを学習することになり必要があれば更新をするようにすることができる.

層をスキップするルートをShortcut Connectionといい、

学習する層を二つ以上スキップする必要がある.

論文によれば最大1201層まで実現可能とのこと. | ResNet特徴 |

| 入力:x

出力:F(x)+x

F(x)が学習する部分

必要がなければ勝手に重みが0になってF(x)が0になると想定される |

最後の出力はGlobal Average Pooling層を用いて1000次元を出力している. | Global Average Pooling層 |

詳しいことは右の元論文を参考にしてください | 外部リンク Residual Netの元論文 |

この章を学んで新たに学べる

Comments