活性化関数

活性化関数

2017.9.13

-

218Views

-

0Watch

-

9Knows

|

|

活性化関数の新規投稿

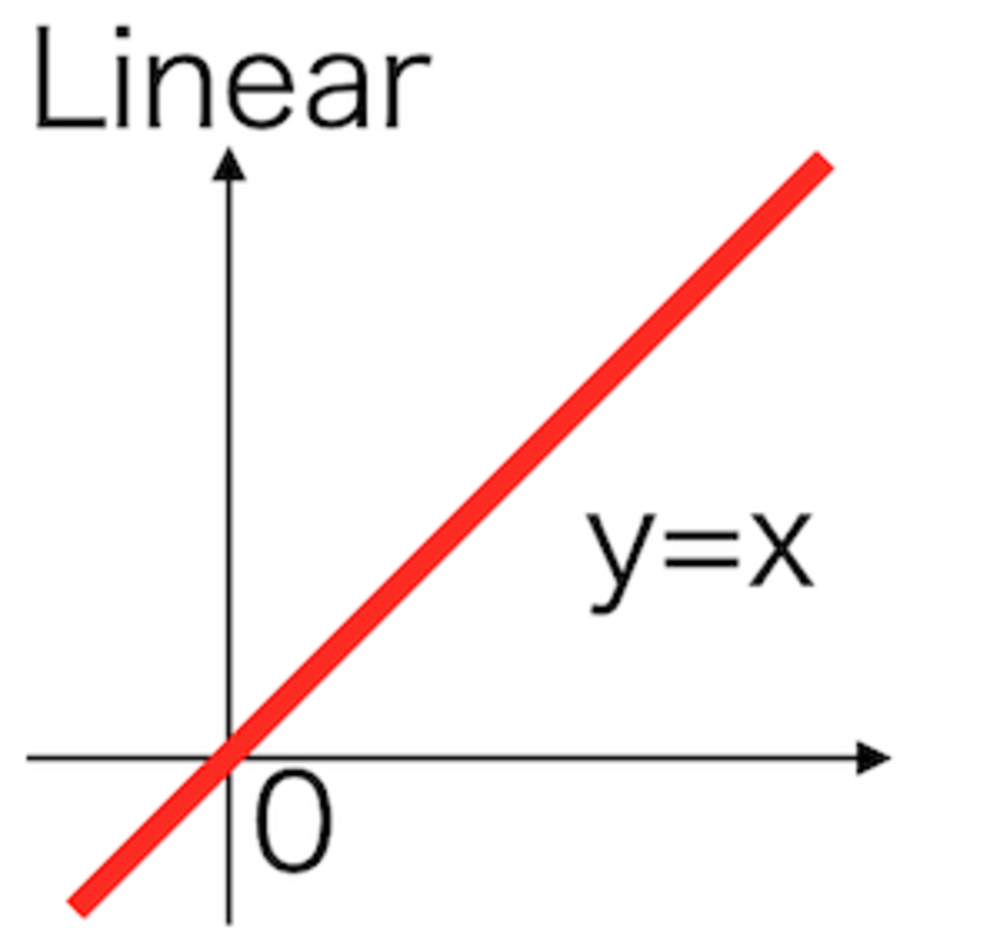

恒等活性化関数

線形活性化関数で傾きa=1とした恒等活性化関数.

ニューラルネットでは通常使用されない.

PV 172

Fav 0

2017.09.13

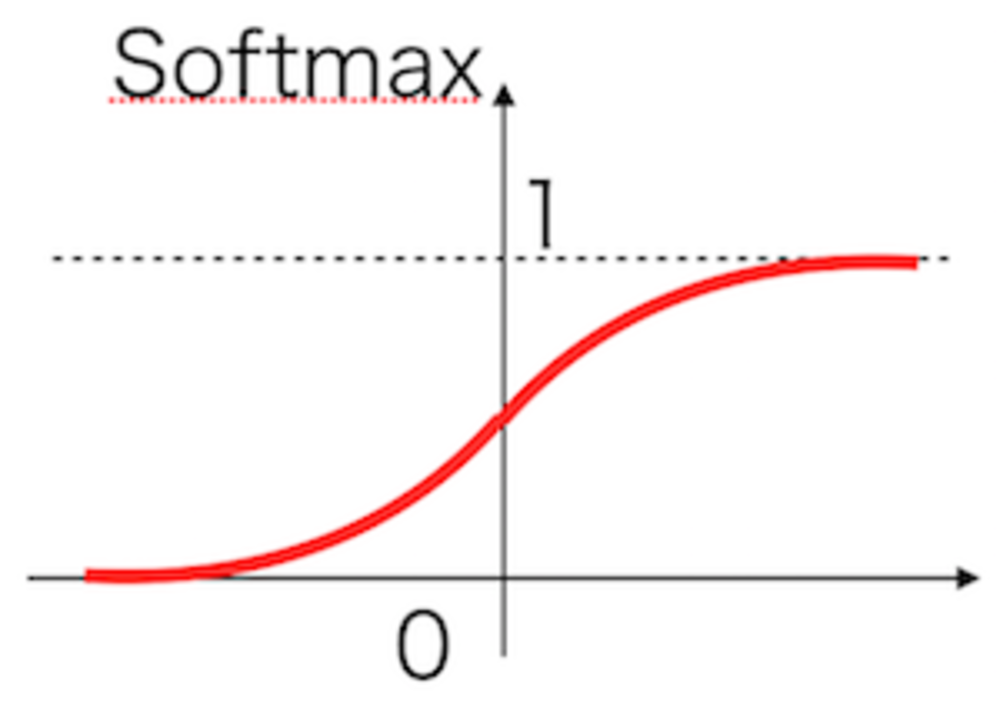

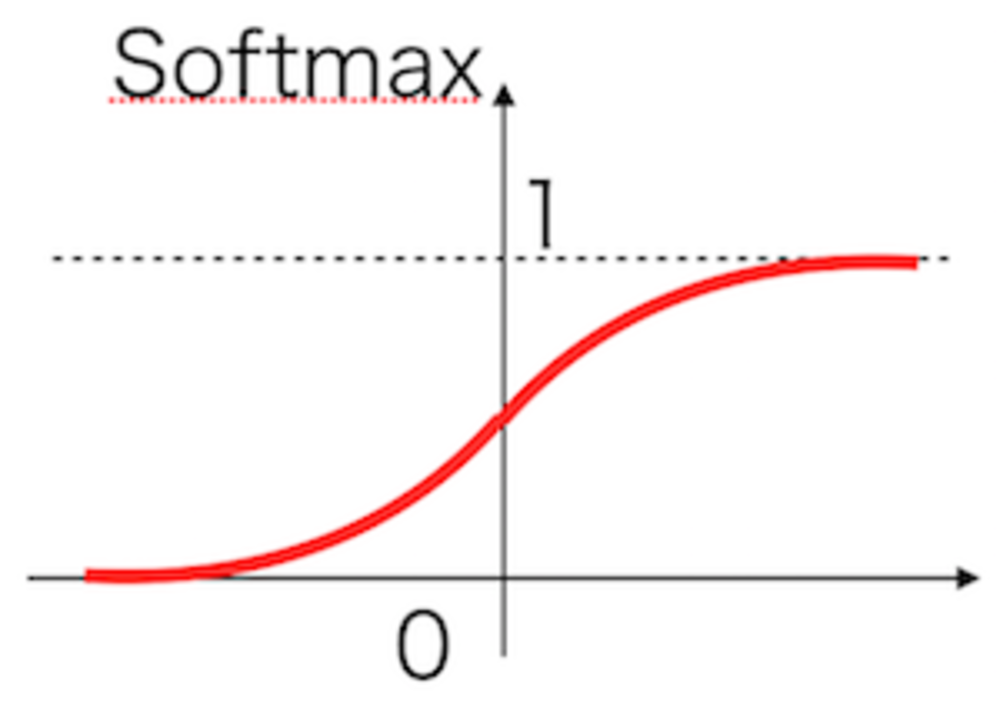

ソフトマックス活性化関数

ソフトマックスは複数の値があるときに、それらの合計が1になり各出力が0から1の値になるように調整してくれる活性化関数.

PV 216

Fav 0

2017.09.13

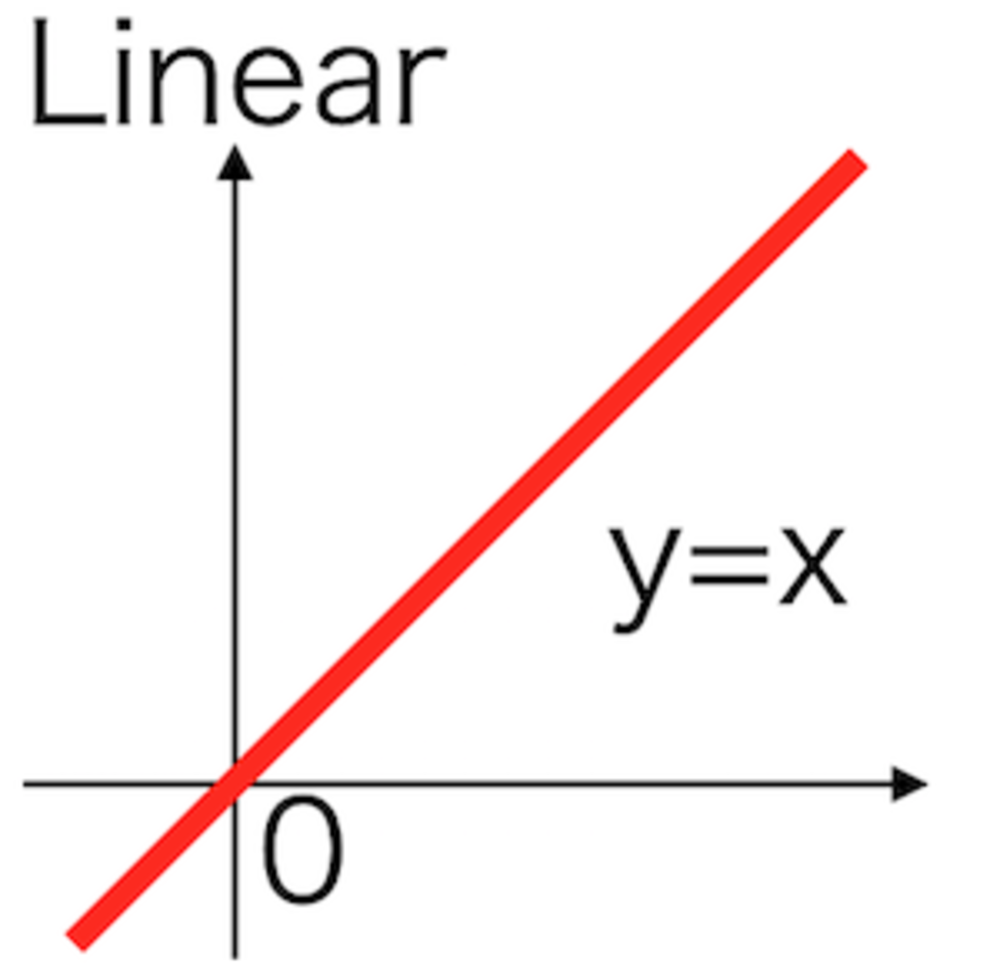

線形活性化関数

y=axで定められる入力に対して線形な出力値を出す活性化関数.絶対に使われない.

効果的な学習を行うには活性化関数は常に非線形活性化関数を使う必要がある.

PV 205

Fav 0

2017.09.13

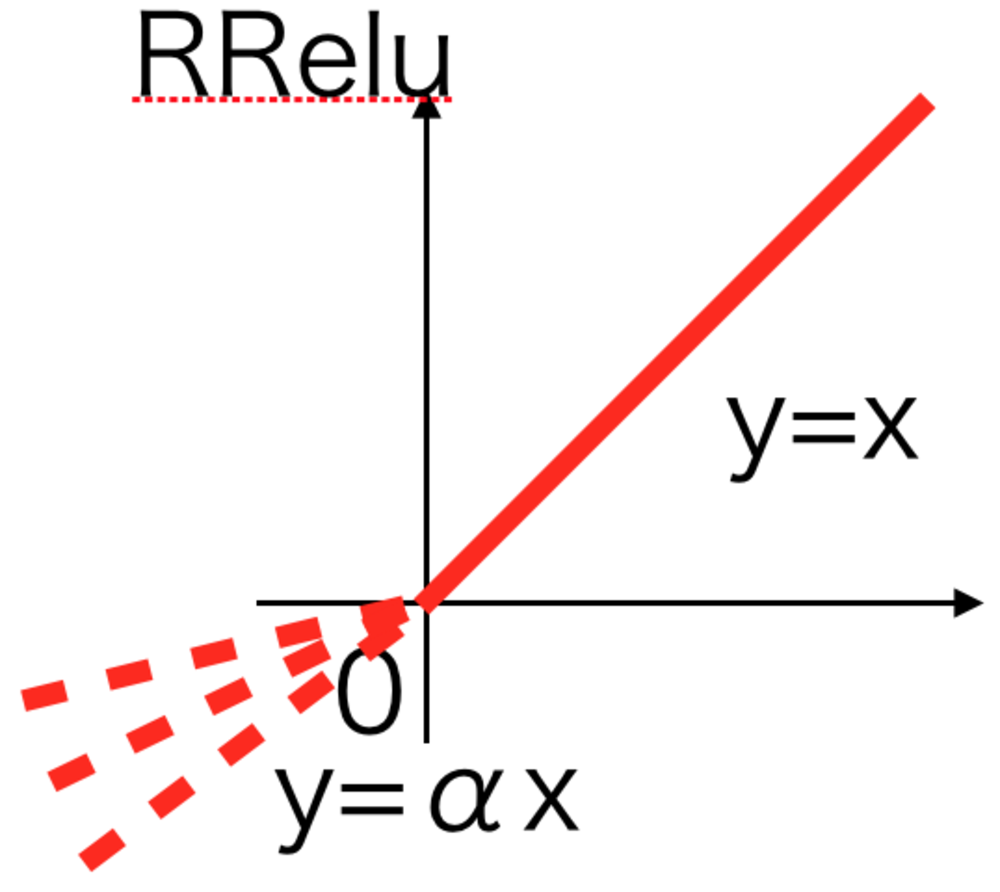

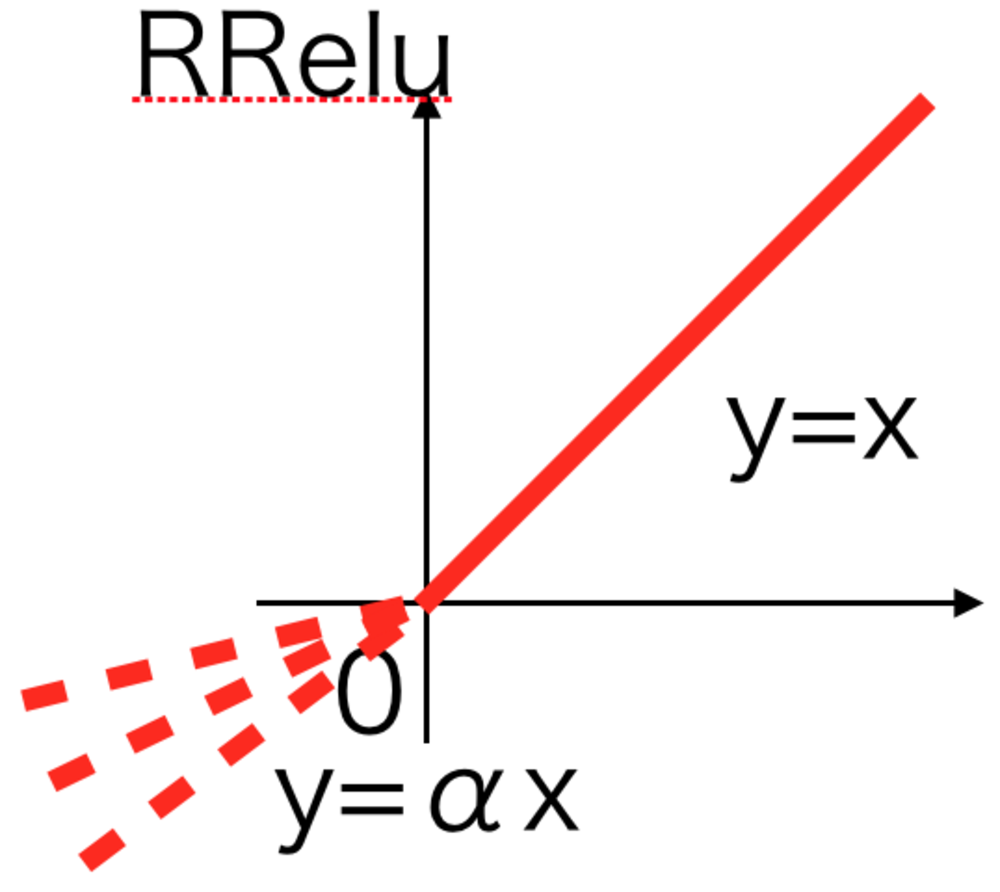

RRelu活性化関数

PReluでは傾きを学習していたが、RReluではある幅の中で傾きをランダムにしている.

Randomized Leaky Relu活性化関数と呼ばれる.

PV 386

Fav 0

2017.09.13

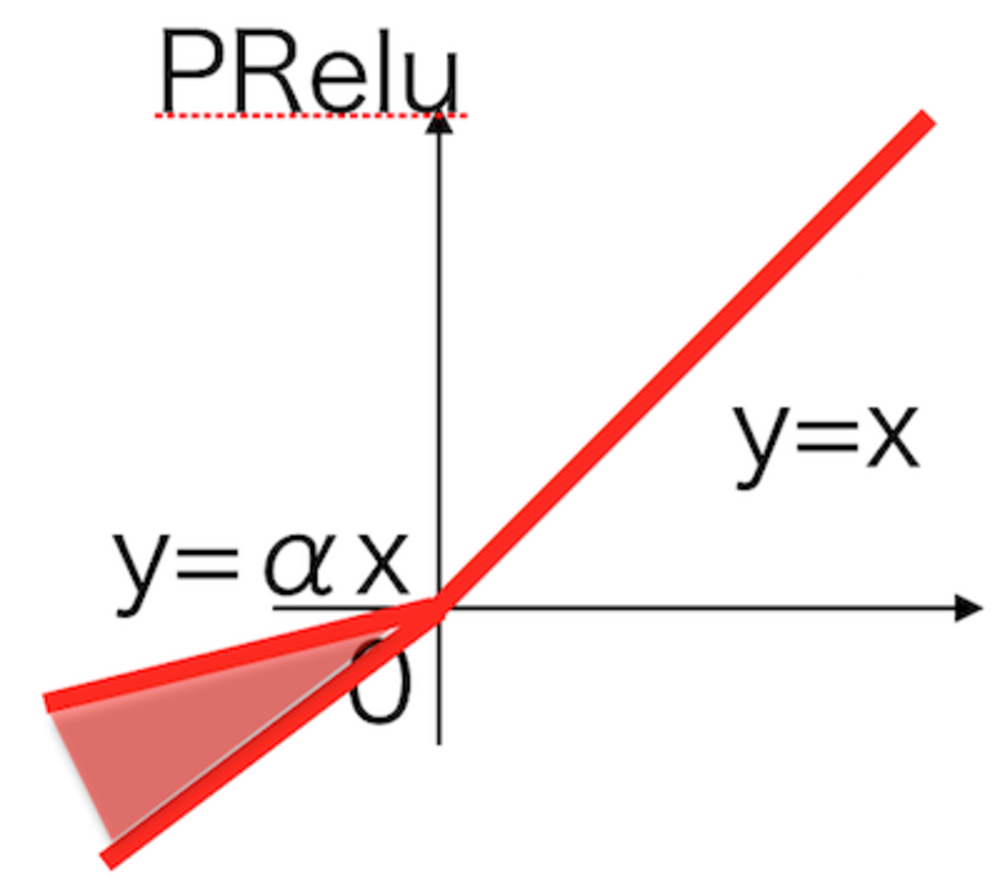

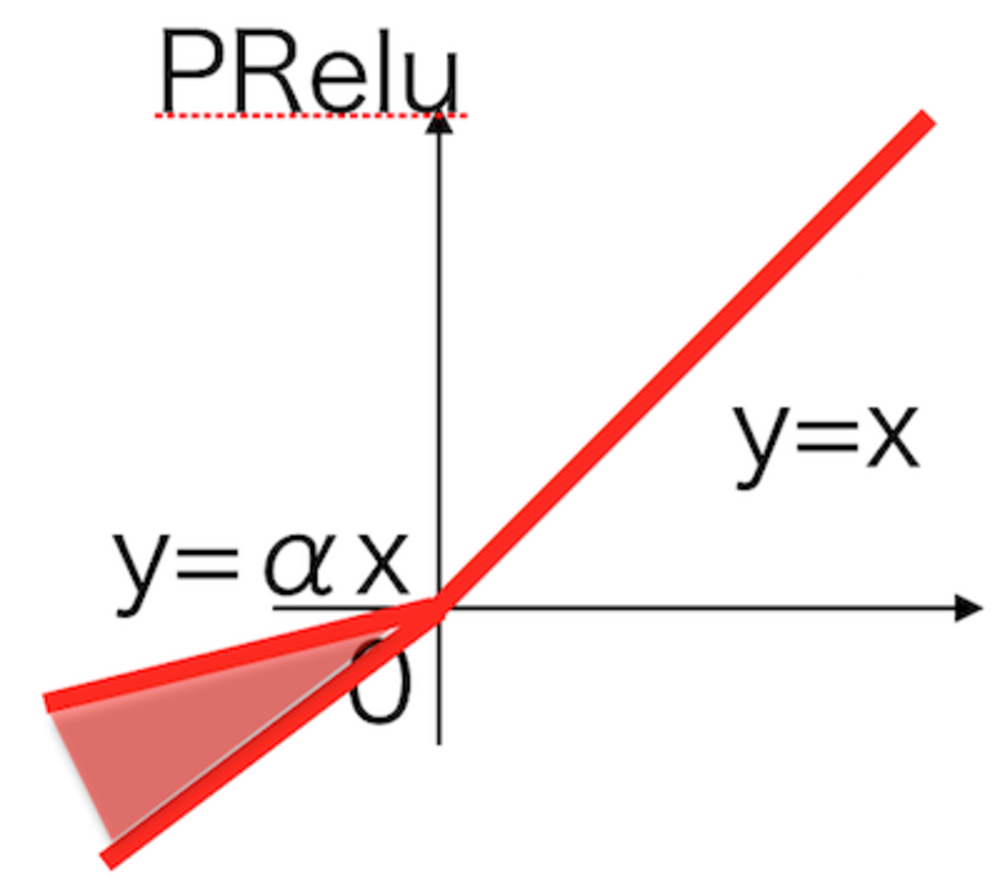

PRelu活性化関数

LeakyReluを改良して、学習しながら適切な傾きを変更していく.

PRelu活性化関数.

PV 530

Fav 0

2017.09.13

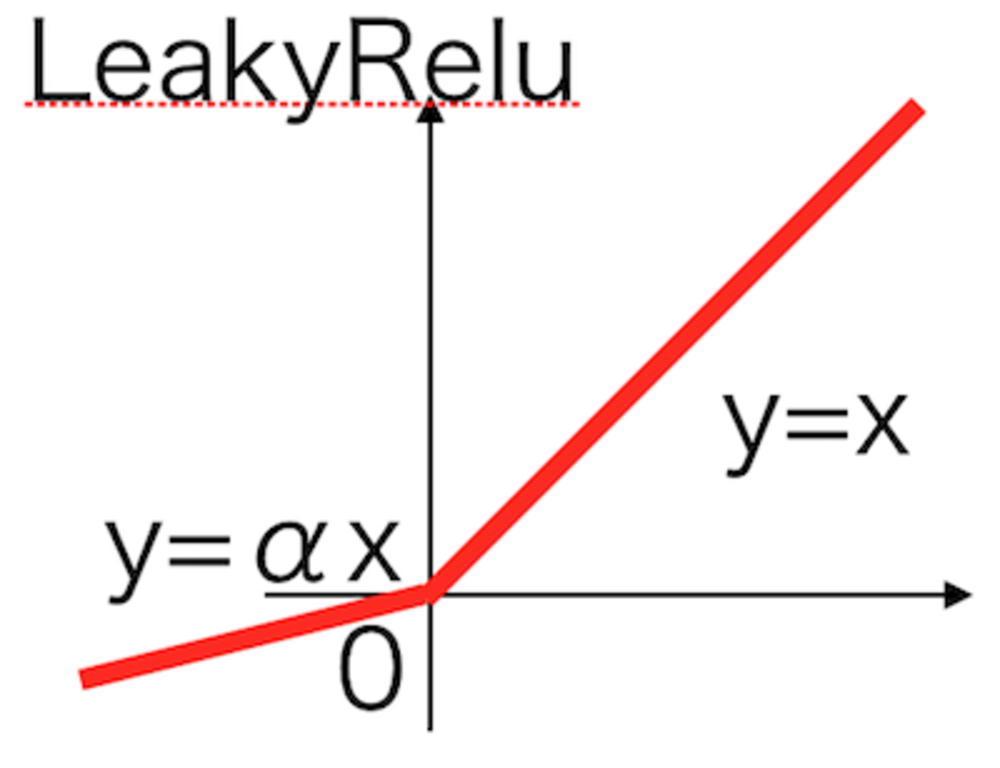

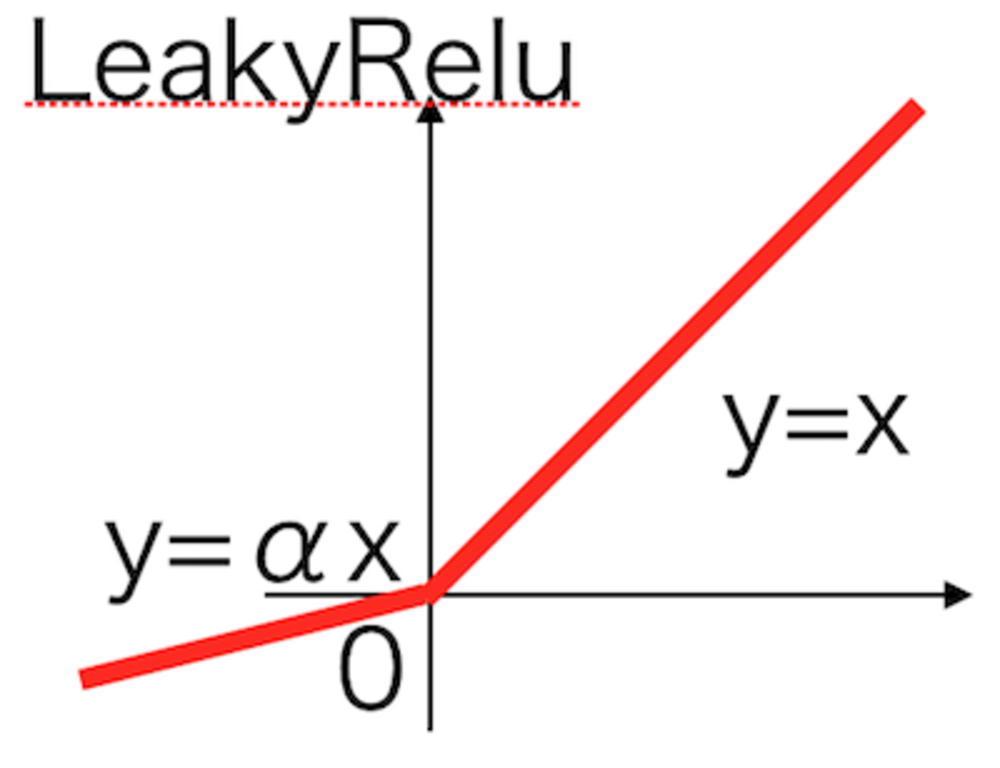

LeakyRelu活性化関数

Reluでxが負の場合を改良したLeakyRelu活性化関数.

PV 680

Fav 0

2017.09.13

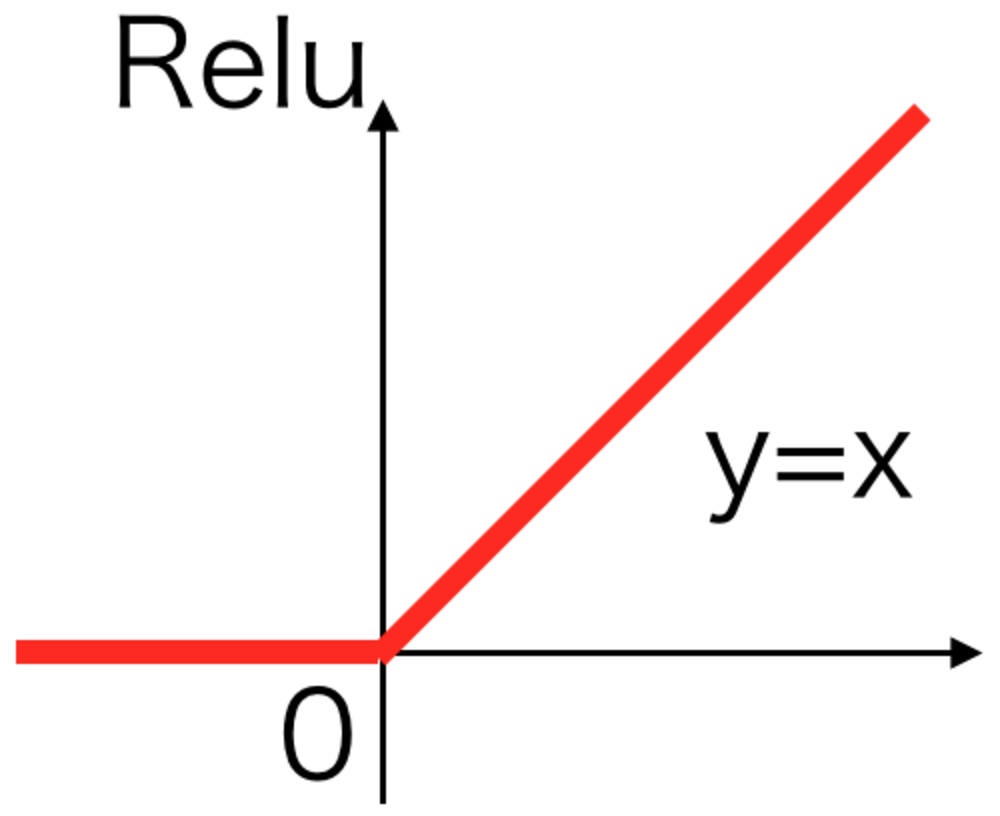

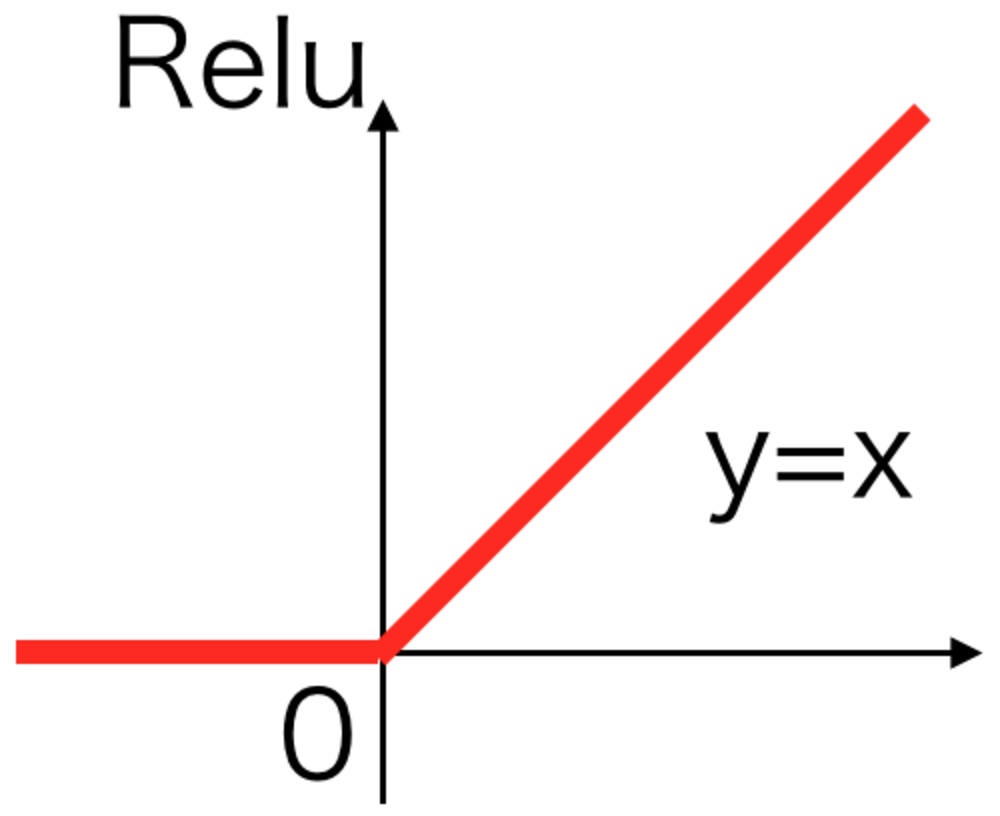

Relu活性化関数

最も現在使われることの多い活性化関数。

xが負のとき0それ以外は恒等関数.

シグモイドなどより計算が早いことが特徴.

PV 865

Fav 0

2017.09.13

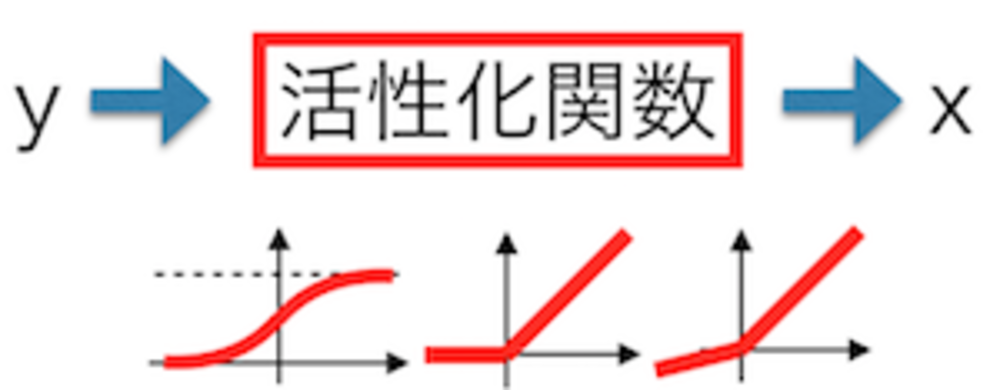

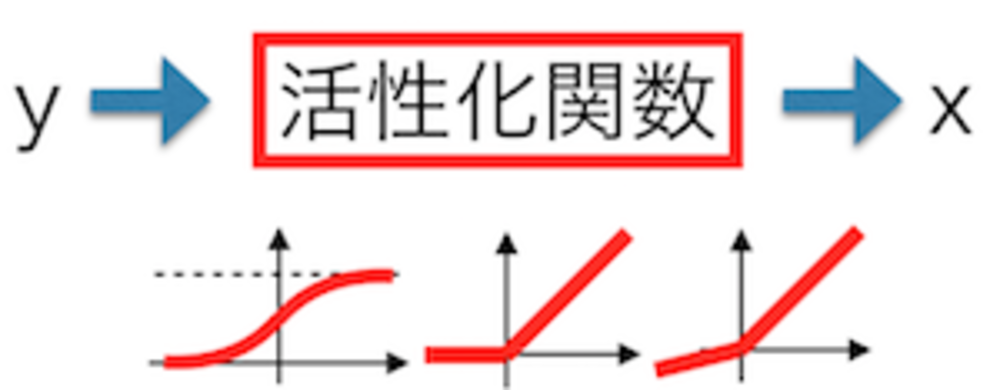

活性化関数とは

Deep Learningで層の出力の際に必ず使われる活性化関数。

活性化関数は、そのニューロンの出力を補正してやる役割があり、発散等を防いでいます。これらはネットワークの表現力を高くするために常に非線形関数が用いられます.

PV 414

Fav 0

2017.09.13

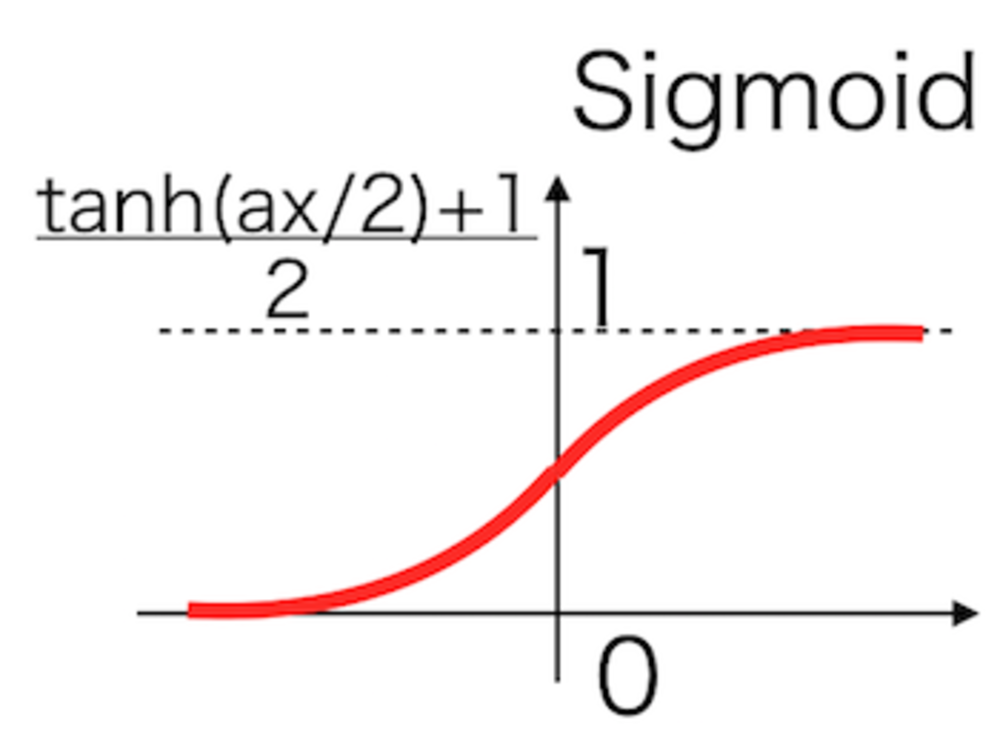

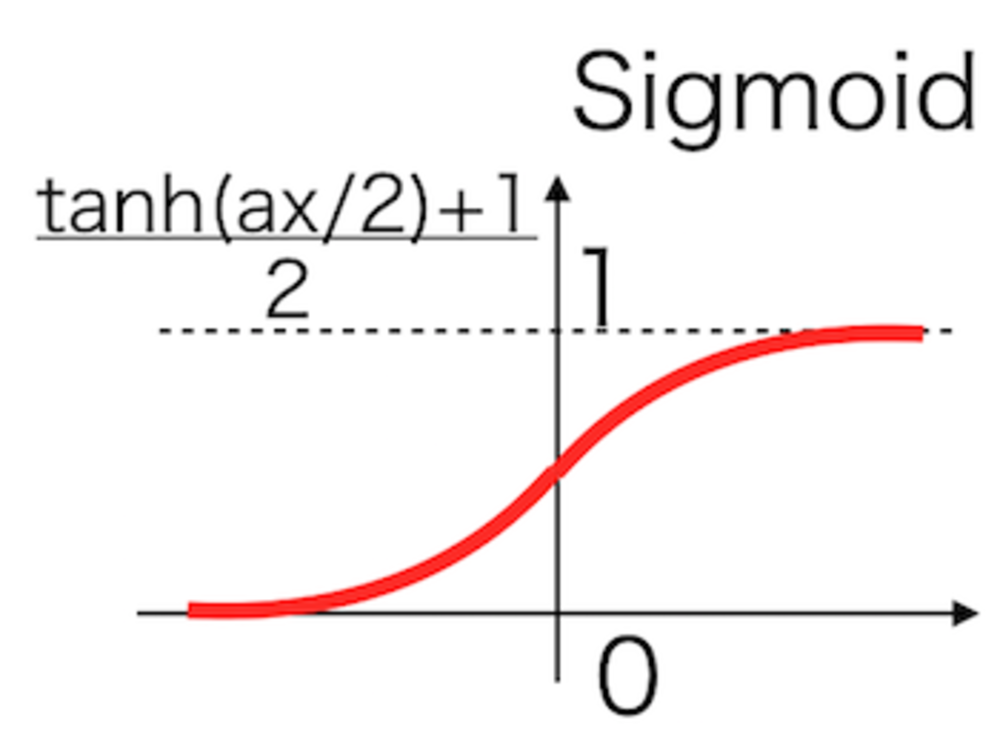

Sigmoid活性化関数

1990年代まで最も長らく使われていたニューラルネットの活性化関数.

人間のニューロンの入出力にヒントを得て設計され、微分も用意なため重宝されてきたが、勾配消失問題の原因になっているため、現在では使われない.

PV 404

Fav 0

2017.09.13

活性化関数人気知識・質問

Relu活性化関数

最も現在使われることの多い活性化関数。

xが負のとき0それ以外は恒等関数.

シグモイドなどより計算が早いことが特徴.

PV 865

Fav 0

2017.09.13

LeakyRelu活性化関数

Reluでxが負の場合を改良したLeakyRelu活性化関数.

PV 680

Fav 0

2017.09.13

PRelu活性化関数

LeakyReluを改良して、学習しながら適切な傾きを変更していく.

PRelu活性化関数.

PV 530

Fav 0

2017.09.13

活性化関数とは

Deep Learningで層の出力の際に必ず使われる活性化関数。

活性化関数は、そのニューロンの出力を補正してやる役割があり、発散等を防いでいます。これらはネットワークの表現力を高くするために常に非線形関数が用いられます.

PV 414

Fav 0

2017.09.13

Sigmoid活性化関数

1990年代まで最も長らく使われていたニューラルネットの活性化関数.

人間のニューロンの入出力にヒントを得て設計され、微分も用意なため重宝されてきたが、勾配消失問題の原因になっているため、現在では使われない.

PV 404

Fav 0

2017.09.13

RRelu活性化関数

PReluでは傾きを学習していたが、RReluではある幅の中で傾きをランダムにしている.

Randomized Leaky Relu活性化関数と呼ばれる.

PV 386

Fav 0

2017.09.13

ソフトマックス活性化関数

ソフトマックスは複数の値があるときに、それらの合計が1になり各出力が0から1の値になるように調整してくれる活性化関数.

PV 216

Fav 0

2017.09.13

線形活性化関数

y=axで定められる入力に対して線形な出力値を出す活性化関数.絶対に使われない.

効果的な学習を行うには活性化関数は常に非線形活性化関数を使う必要がある.

PV 205

Fav 0

2017.09.13

恒等活性化関数

線形活性化関数で傾きa=1とした恒等活性化関数.

ニューラルネットでは通常使用されない.

PV 172

Fav 0

2017.09.13