DeepLearning

近年注目されている機械学習技術の一つです。ハードウェアの高性能化により以前できなかったような学習ができるようになったことも影響しています。

画像認識、音声認識、時系列データ処理、強化学習、分類、回帰等を行う多層ニューラルネットワークです。

2017.9.3

-

600Views

-

3Watch

-

73Knows

-

一つ上へ

-

層の種類DeepLearningは複数の層をつなげることで一つのネットワークを構築します。その際に層にはいくつもの種類があり、目的に応じてどの層を選ぶかが異なってきます。 例えば画像処理でよく用いられるConvolution層、Convolution層の次の層に挟まれることの多いPooling層があります。

-

ネットワーク構造過去に性能を発揮し有名となっているネットワークを列挙しておきます。これらをベースいくつもの発展させたネットワークが作成されています。

-

最適化関数最適化関数

-

DeepLearningとはDeep Learning(深層学習)の基本事項に関する情報をまとめています。

-

活性化関数活性化関数

-

ニューラルネット学習の工夫学習の工夫

-

学習以外における技術可視化といった学習以外に関係する技術についてまとめる。

-

DeepLearningを使った技術例DeepLearningの技術を使って実現されているいくつかの手法、機能についてまとめています.

-

DeepLeariningよくある課題DeepLearningの学習の結果や学習過程において発生する問題、課題についてまとめているページです.

-

損失関数DeepLearningやニューラルネットワークにおいて、特定の関数に沿ってその損失を減らすような学習を行うのが一般的です.

|

|

DeepLearningの新規投稿

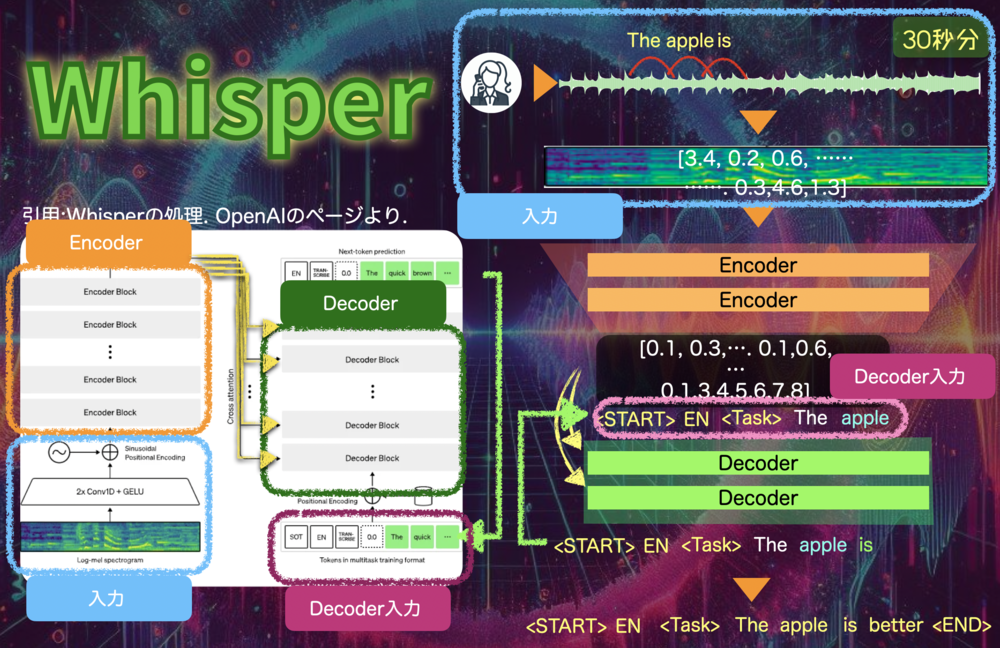

Whisper

WhisperはOpenAIが発表した音声データから文字を読み取る自動音声認識を目的としたAIモデルです.Transformerをベースとしたシンプルな構成で、99言語の文字起こしと翻訳が可能です.モデルサイズごとに性能が異なりますがLargeサイズは人間に遜色ないレベルです.

PV 98

Fav 0

2024.07.06

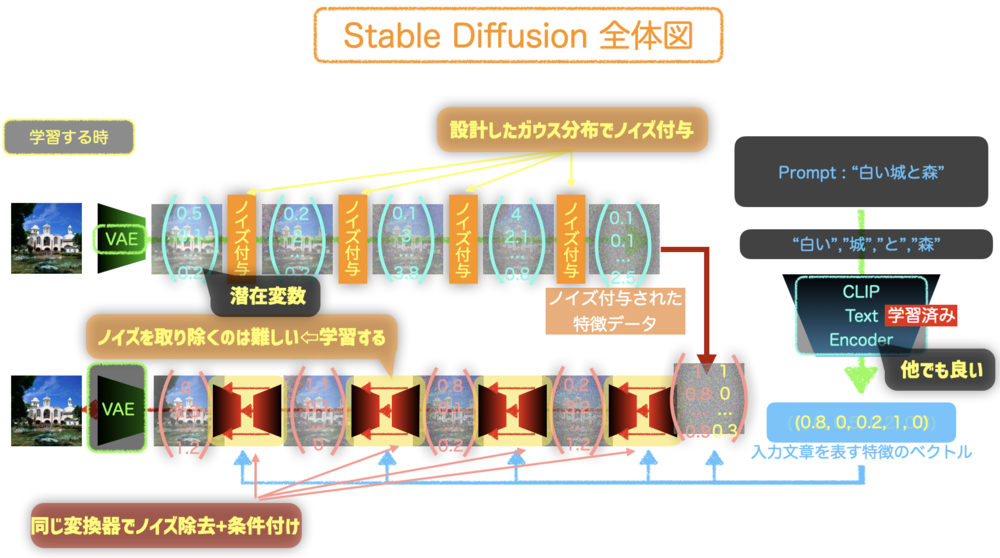

Stable Diffusion

Stable DiffusionはDiffusion Modelをベースとして潜在変数を主に処理しながらユーザのテキスト入力に沿った新しい画像を生成する技術. Stable Diffusionの仕組みを簡単に紹介する.

PV 341

Fav 0

2022.09.05

Convolutionの誤差逆伝播

畳み込み層(Convolution層)の誤差逆伝播の計算についてのみまとめているページです.Convolutionの誤差逆伝播では、後続層からの入力と180度回転したConvolution層のパラメータ、順伝播の入力値を使って計算します.

PV 369

Fav 0

2019.01.28

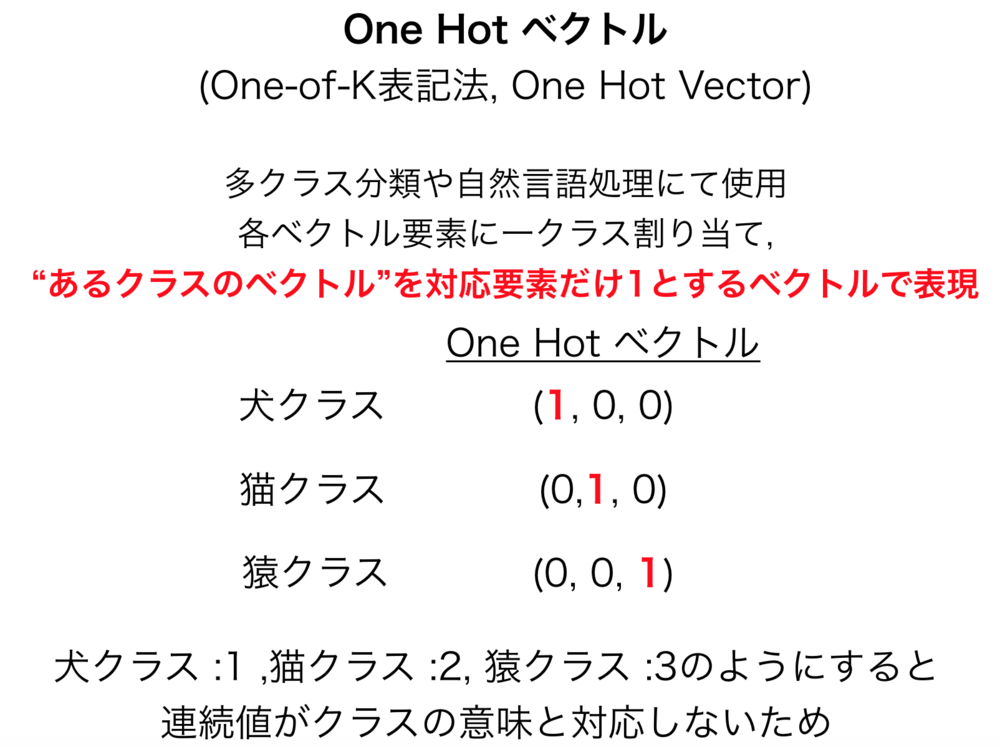

One Hot ベクトル

One Hot ベクトル(One Hot Vector , One-of-K表記法)は、ベクトルの全要素のうち一つだけ1で他は0になっているベクトルをさす.

PV 357

Fav 0

2019.01.10

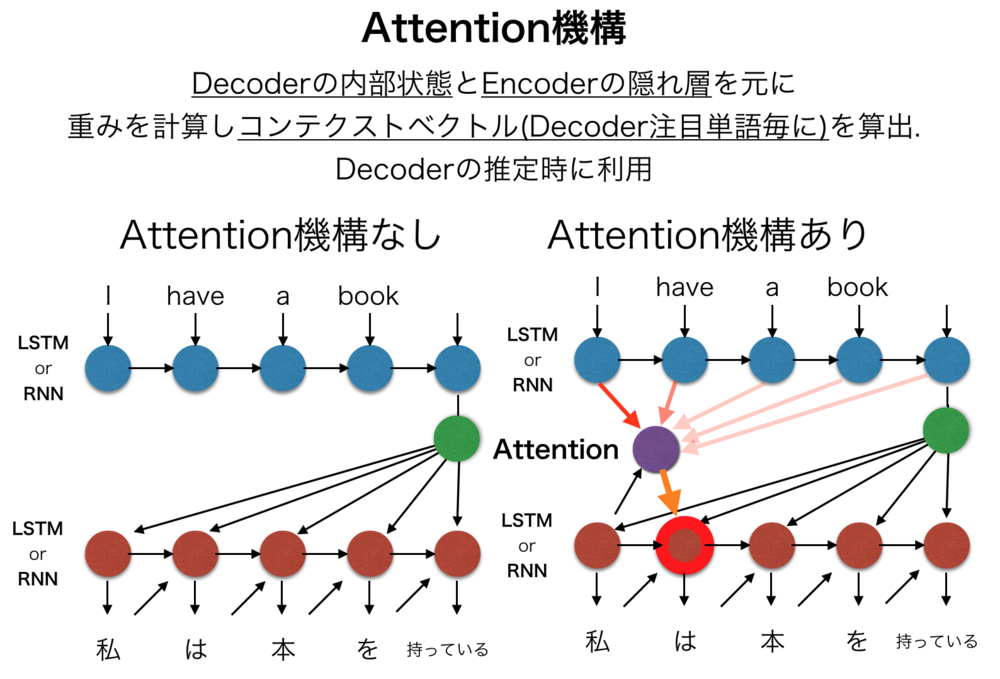

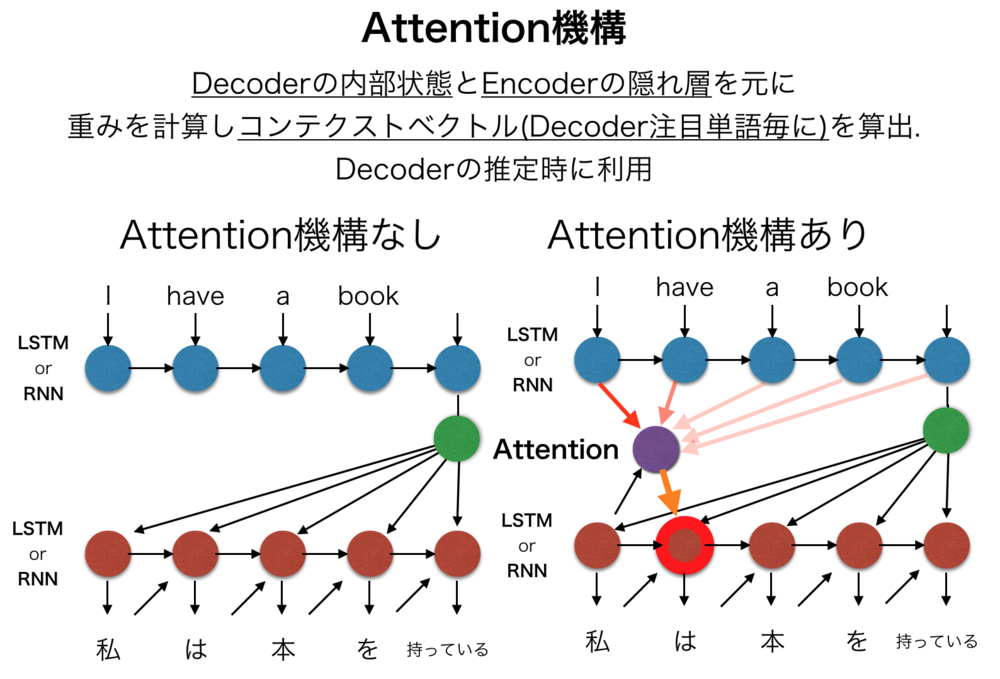

Attention機構

Attention機構(注意機構)とは、主に機械翻訳や画像処理等を目的としたEncoder-Decoderモデルに導入される要素ごとの関係性、注意箇所を学習する機構.機械翻訳において翻訳対象の単語間の関係性や全体のコンテキストを考慮させるために考案されたものだが、画像処理などにおいても応用されている.

PV 1284

Fav 0

2018.12.08

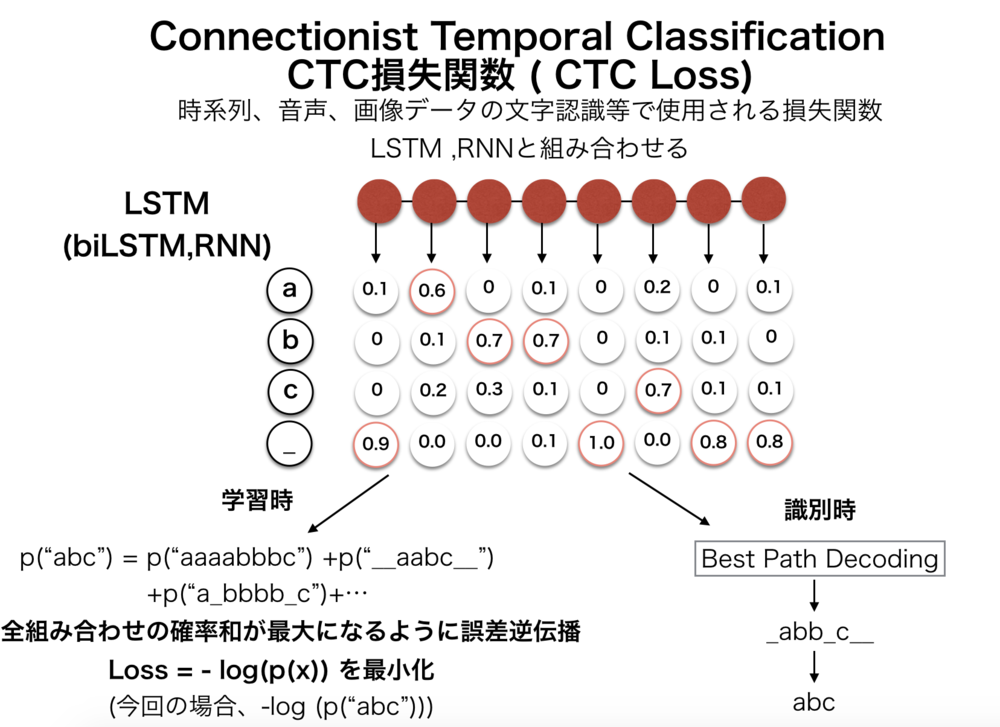

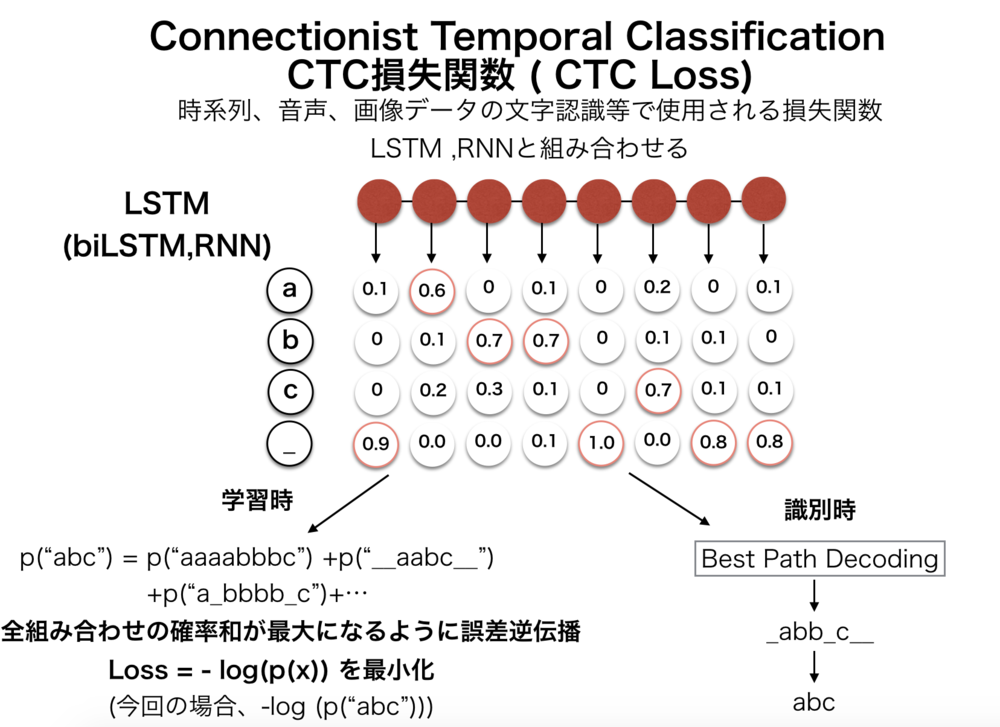

CTC損失関数

CTC Loss(損失関数) (Connectionist Temporal Classification)は、音声認識や時系列データにおいてよく用いられる損失関数で、最終層で出力される値から正解のデータ列になりうる確率を元に計算する損失関数.LSTMやRNNなどの出力を受けて正解文字列の確率を計算する.HMMのように前向き後ろ向きアルゴリズム、動的計画法を元に計算、微分可能であり誤差逆伝播が可能.

PV 1552

Fav 0

2018.12.08

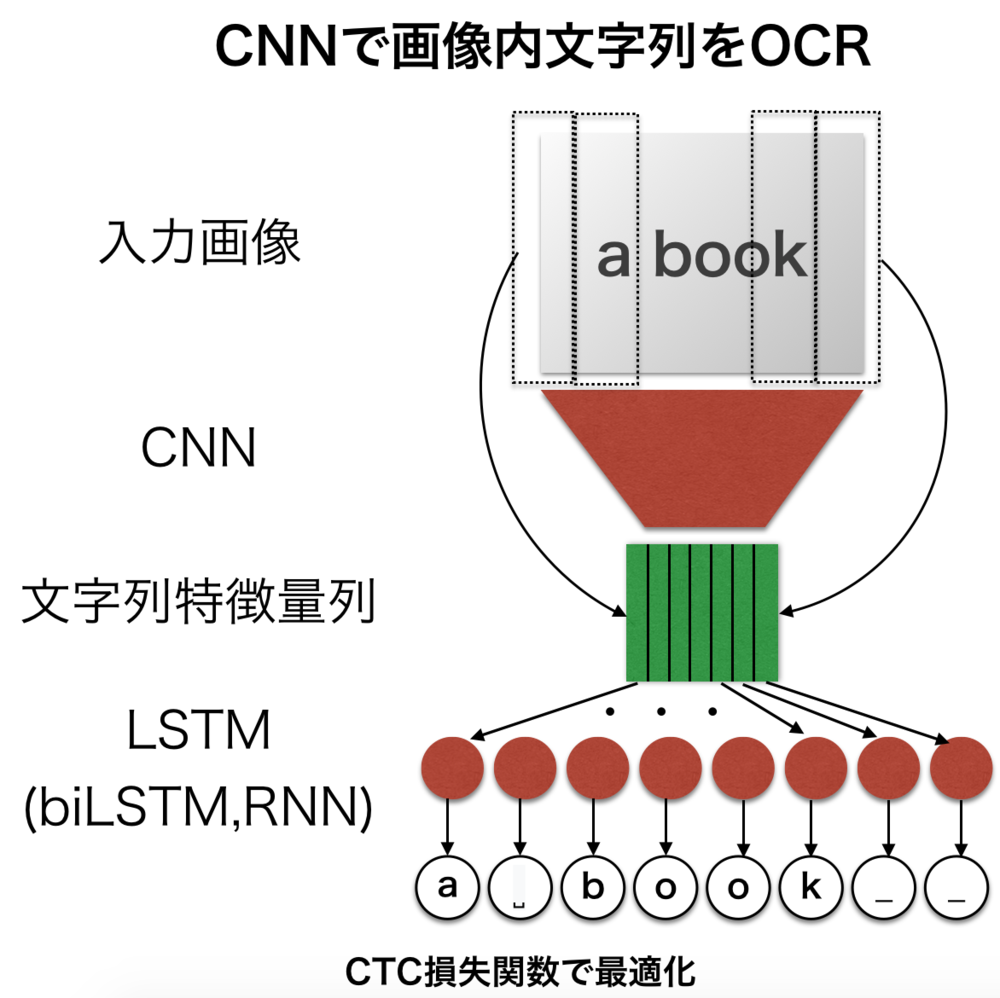

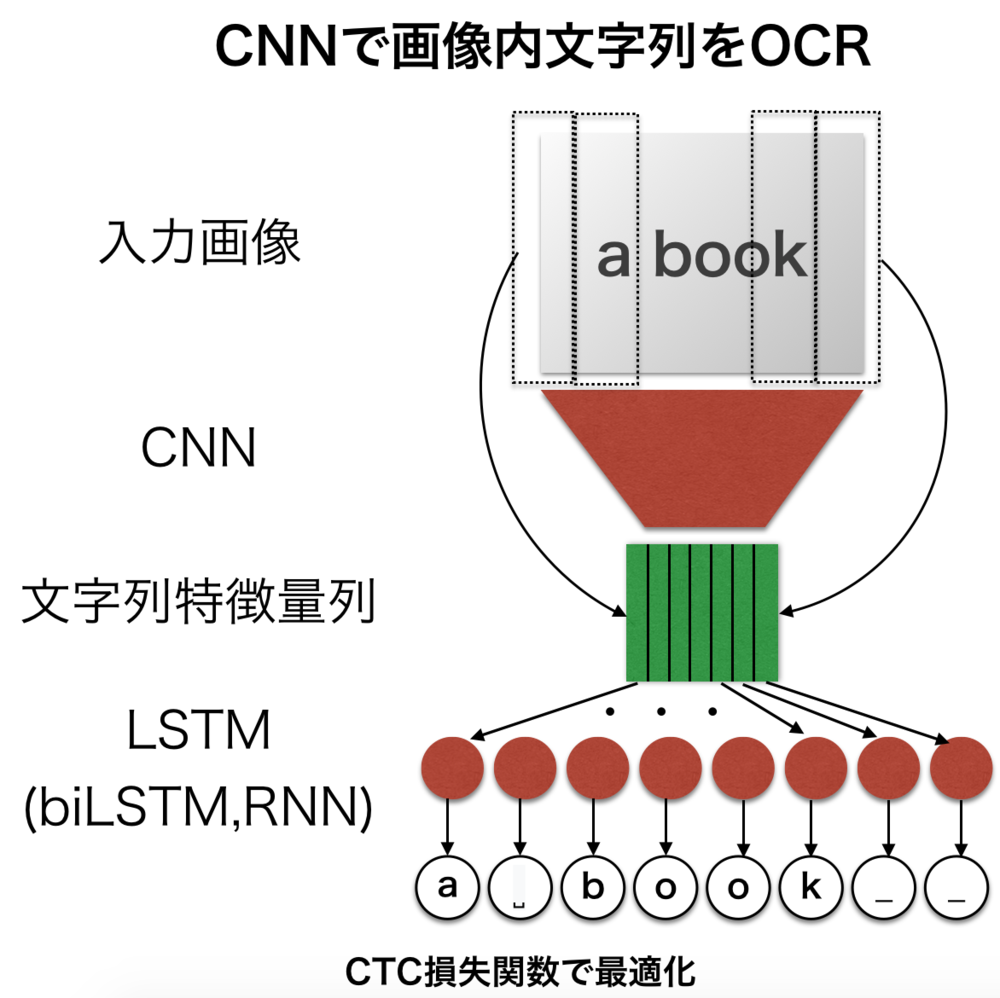

CNNで画像内文字列をOCR

CNNを使って画像の文字列を認識してプログラムで扱える文字列に起こすOCRの例について紹介します.文字列が可変の場合に対応したCNN+LSTMで構成される基本的なネットワークです.

PV 587

Fav 0

2018.12.06

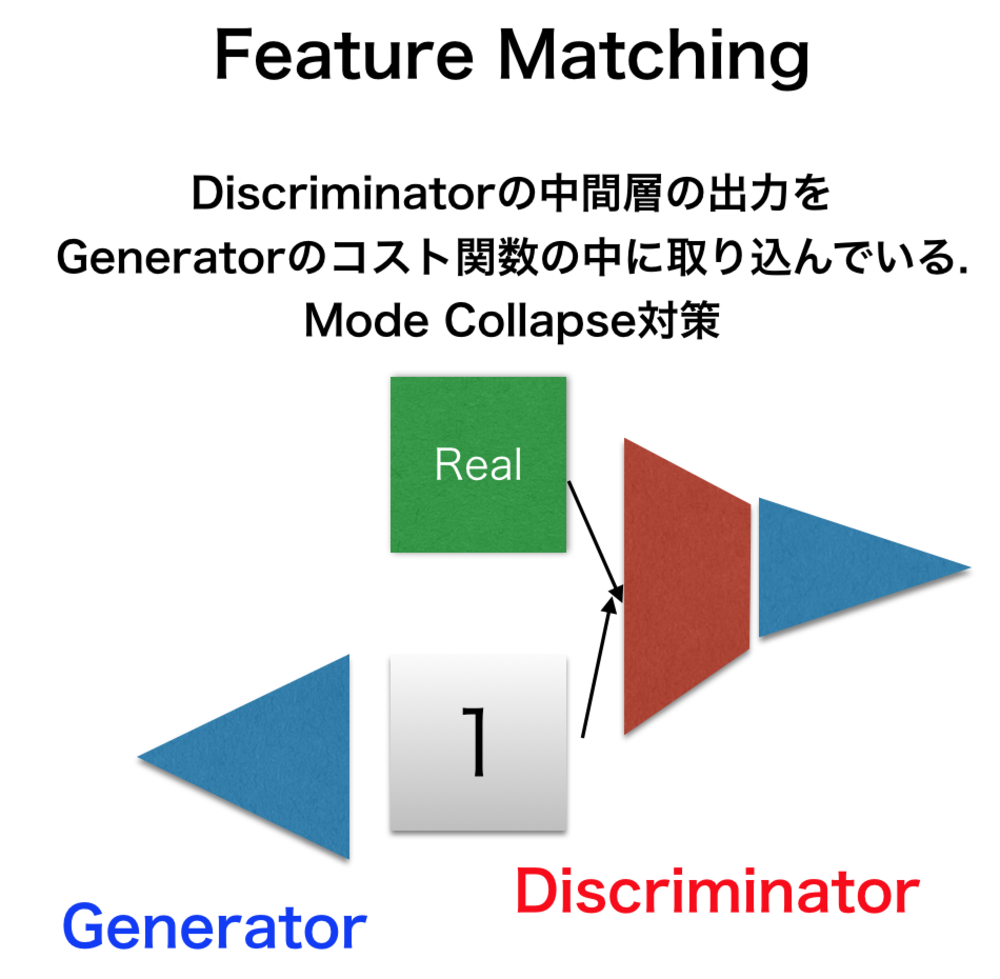

Feature Matching

Feature Matchingとは、GANなどのネットワークで起きるMode Collapseの問題を改善するためにDiscriminatorの中間層を使ってGeneratorのコスト関数を書き換える手法のこと.

PV 220

Fav 0

2018.12.04

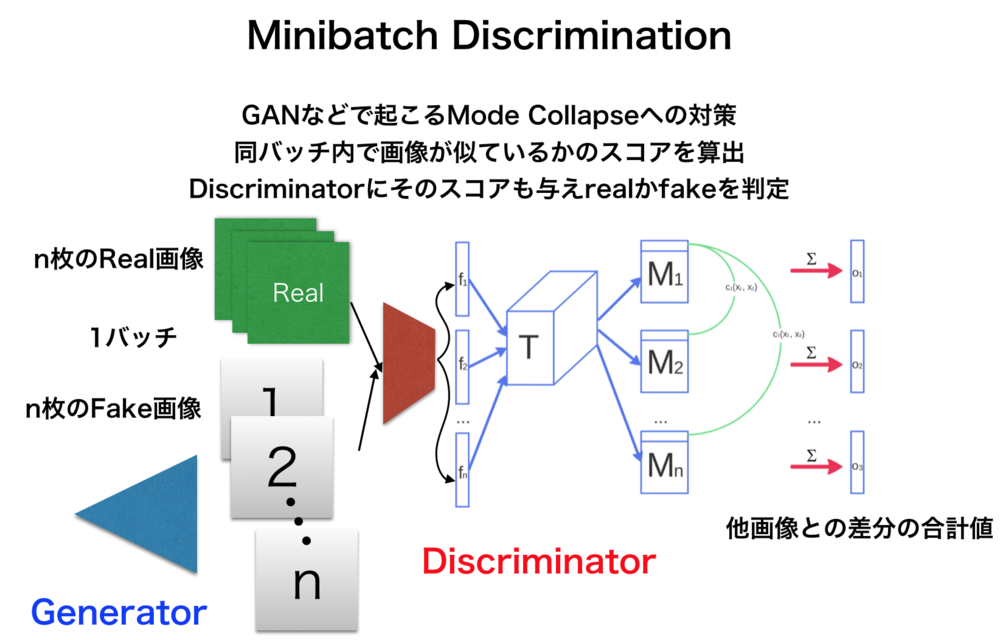

Minibatch Discrimination

Minibatch Discriminationは、GANなどで主に見られるMode Collapseのような問題に対して、複数枚の画像同士が似ているかのスコアをDiscriminatorに与えることで回避する.

PV 281

Fav 0

2018.12.04

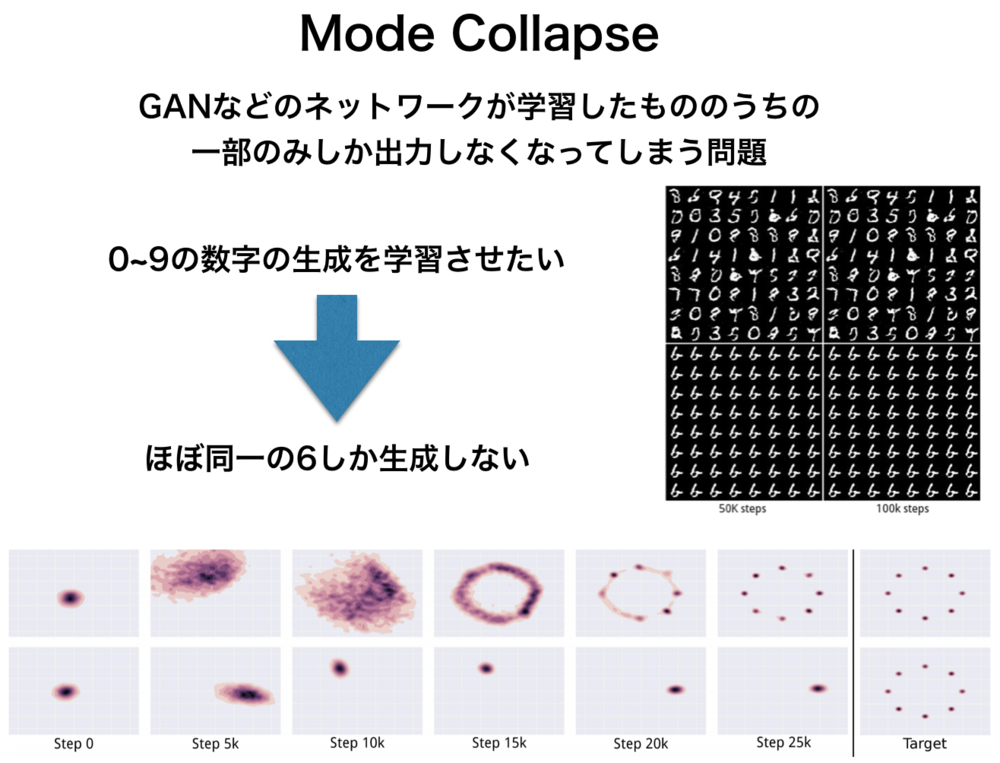

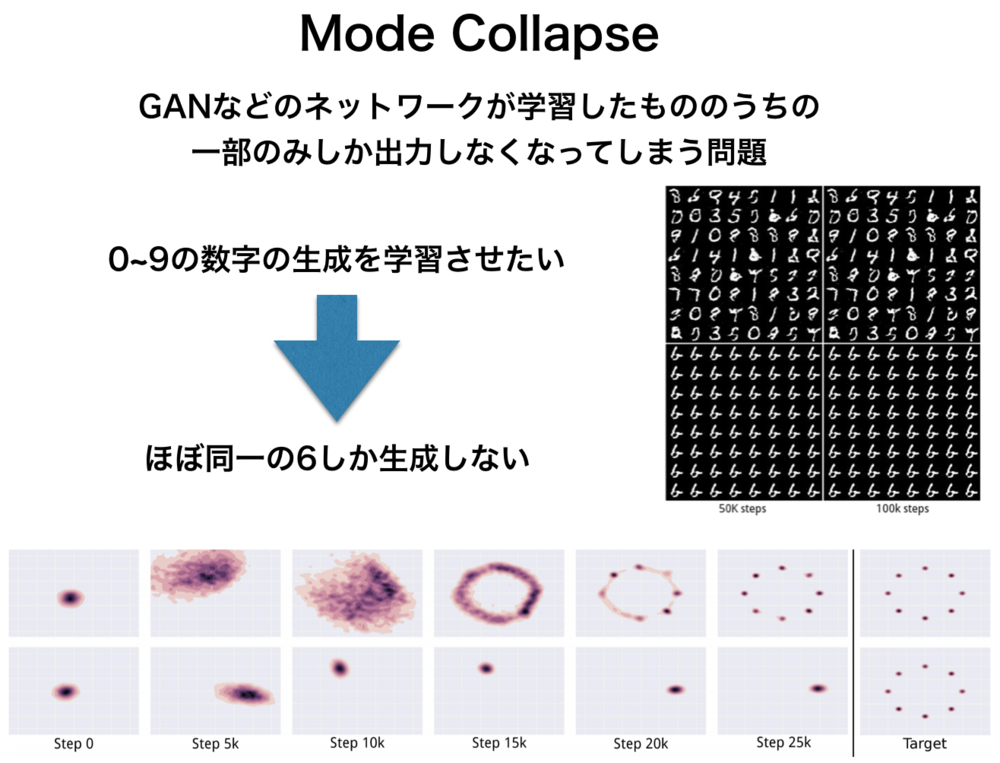

Mode Collapseとは

Mode Collapseとは、GAN等で主に問題となる数種類の結果のみを出力するようになってしまう問題のこと.例えば1から10までの数字の画像生成をさせようと学習しても6ばかり出すようになってしまう.

PV 683

Fav 0

2018.12.04

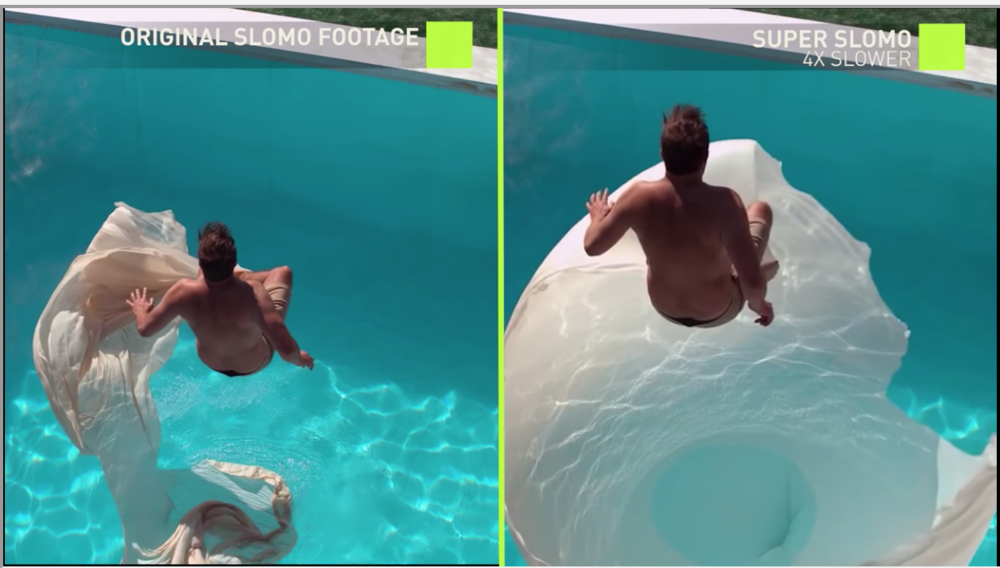

Super Slomo

Super SlomoはNVidiaによって発表されたスローモーションを実現するために作成されたフレーム間補間を行う技術.Convolutional Neural Network(CNN, Unet)を主に用いている.

PV 242

Fav 0

2018.10.21

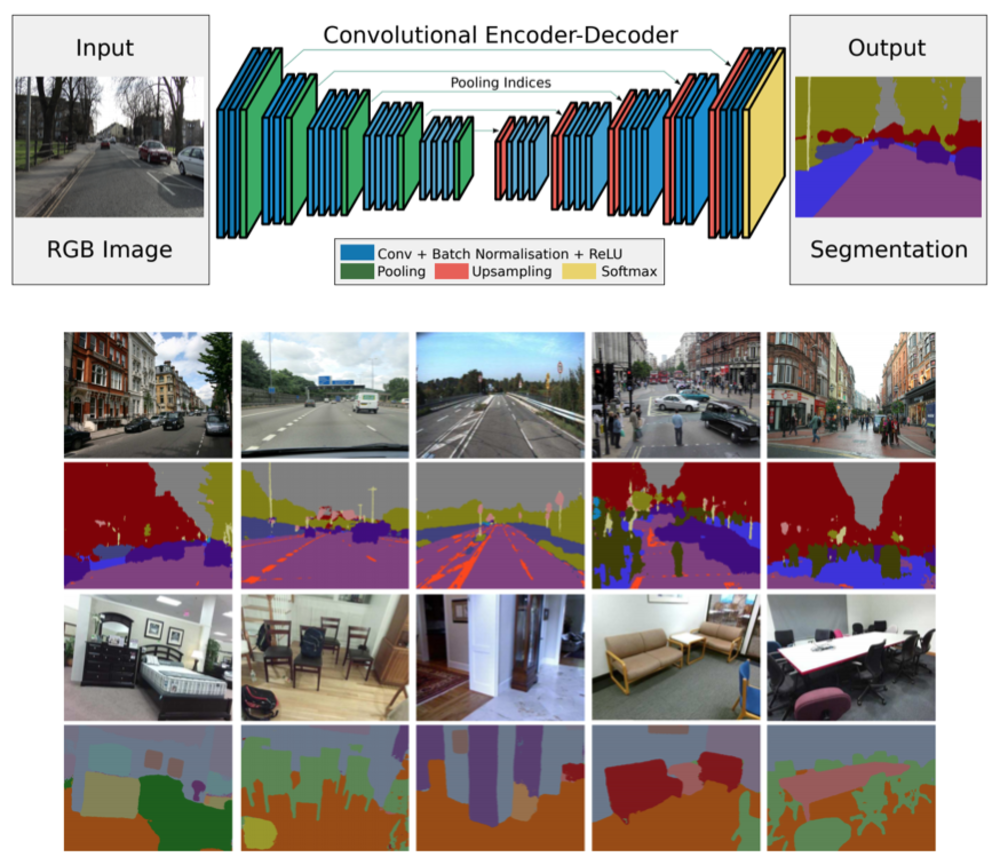

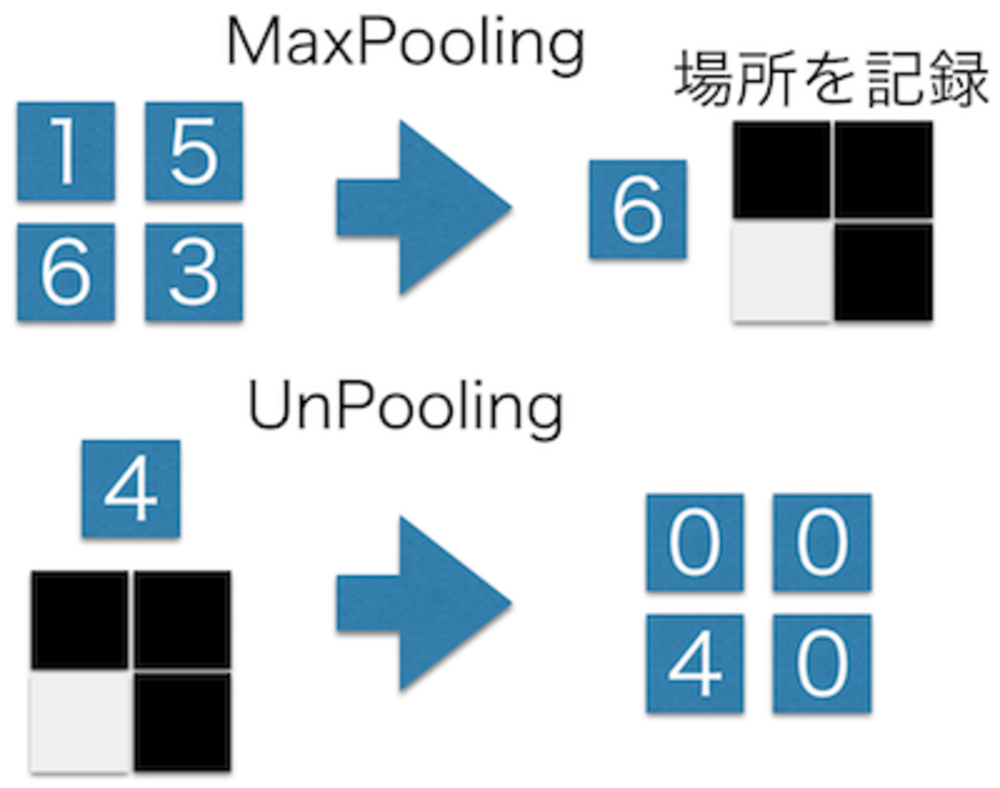

SegNet

SegNetはFCNより解像度よくSemanticSegmentationを行うことができるネットワーク.UnPooling層をDecoderに用いることでより細かい領域分割ができることを可能にした.またUnpoolingを用いて省メモリになったことも特徴.

PV 218

Fav 0

2018.09.16

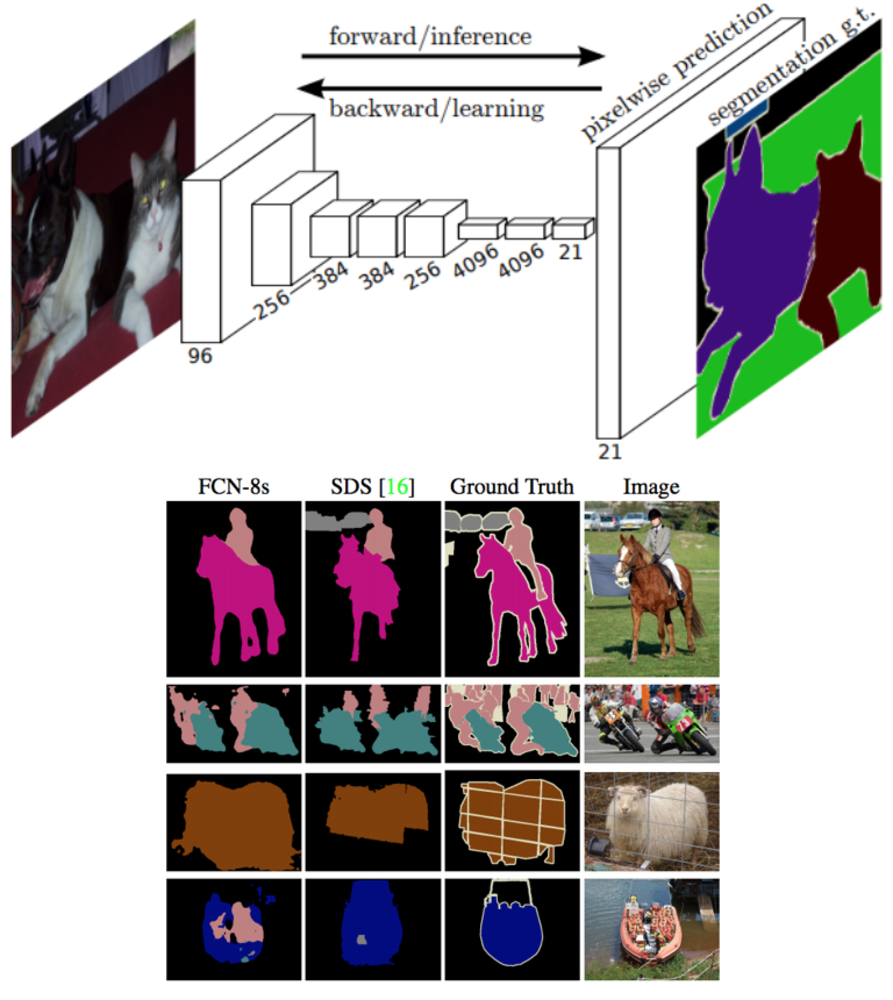

FCN (Semantic Segmentation)

FCN(Fully Convolutional Networks for Semantic Segmentation)は、FCNのネットワーク構造を用いてSemantic Segmentation(領域のクラス分類)を行っているネットワークです.ピクセルレベルでなんの物体なのかを推定します.全結合層を含まないためどのような大きさの画像に対しても適用できるのが特徴ですが、解像度が低くなりがちでまた境界あたりは分類の精度が低く曖昧になりがちです.

PV 256

Fav 0

2018.09.16

SAGAN

SAGAN(Self Attention Generative Adversarial Network)はACGANやSNGANでも扱う画像生成タスクにおいてSelf Attention機構を導入することで高精度な画像生成を実現したネットワーク.

PV 350

Fav 0

2018.07.15

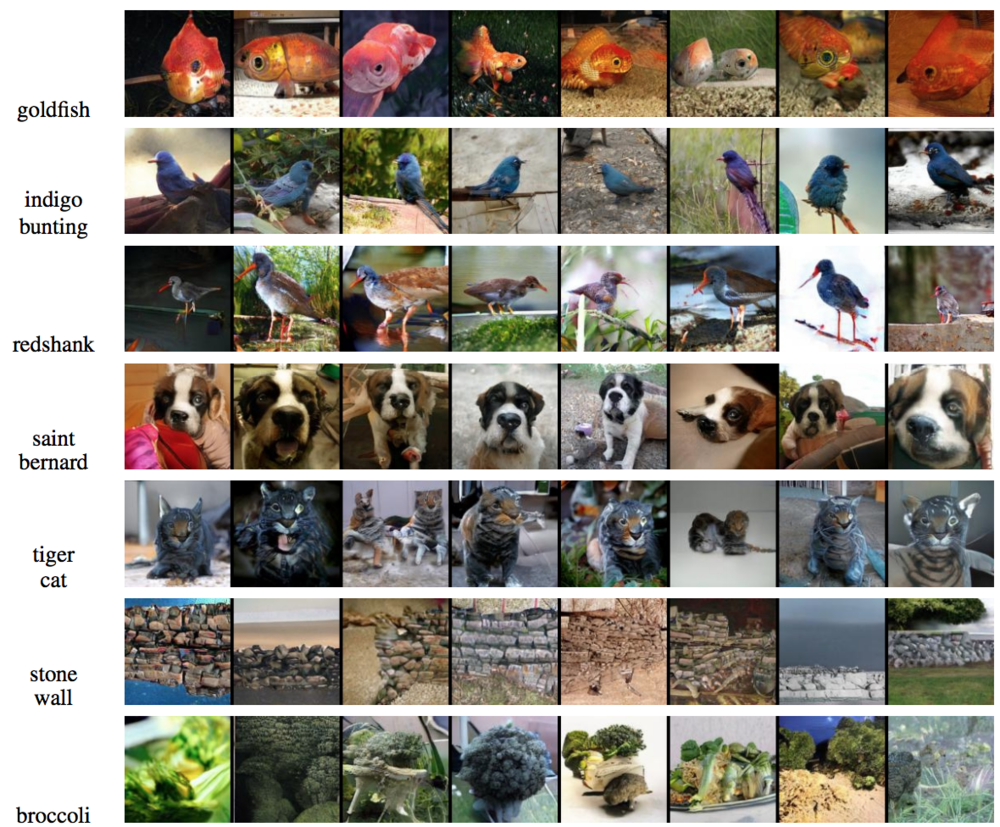

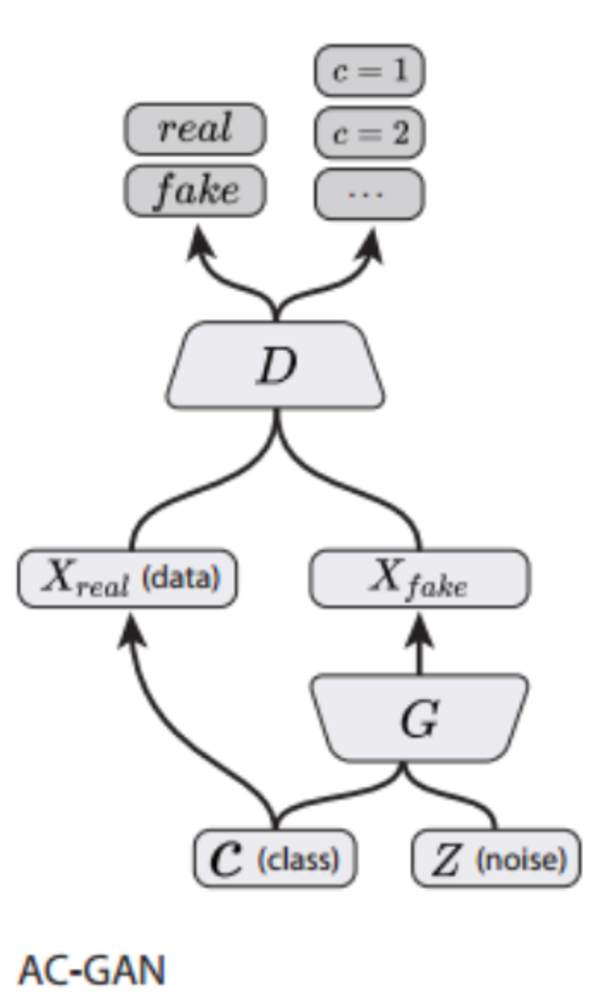

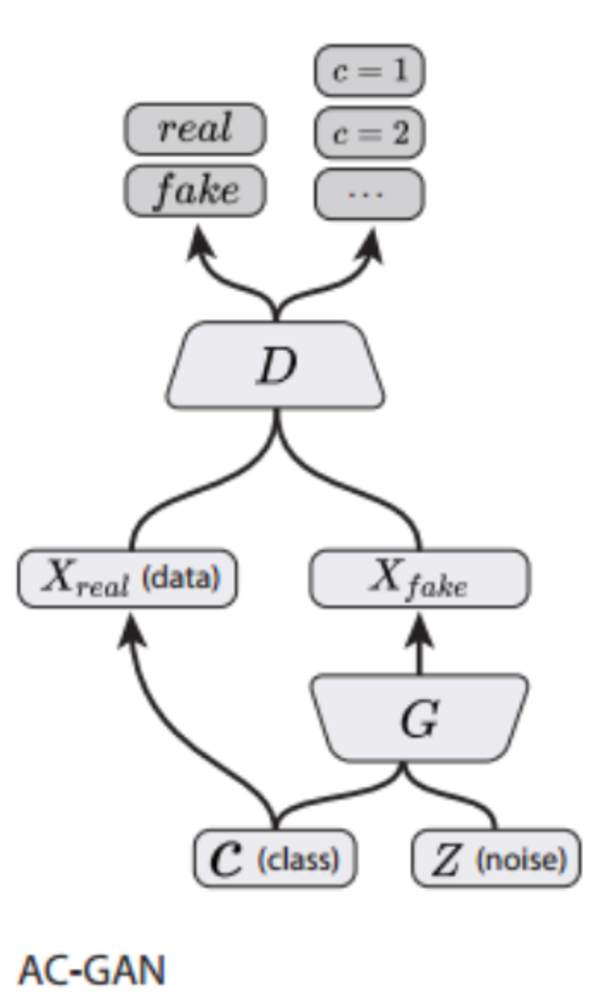

ACGAN

ACGAN(Auxiliary Classifier Generative Adversarial Network)は、DCGANではランダムノイズ列から画像を作っていただけにすぎない学習に加えて、画像のクラスラベル情報をGeneratorに入力しDiscriminatorで補助的なクラス識別タスクを行うことで、高精度な画像を生成できたネットワーク.学習は128x128の画像を入力としてImageNetの画像を使用している.

PV 389

Fav 0

2018.07.15

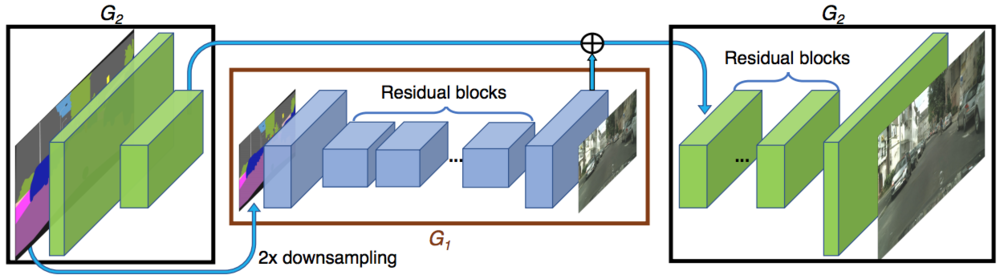

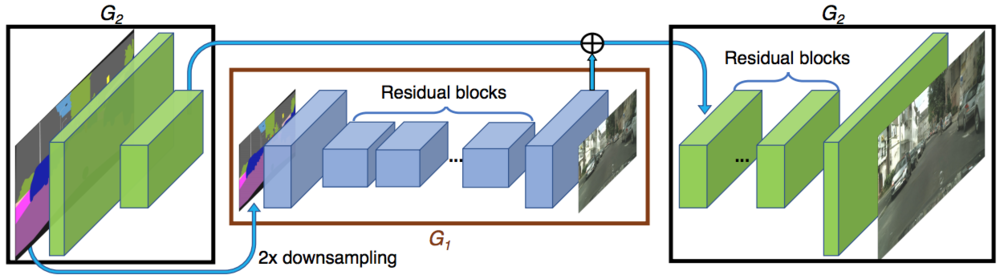

pix2pixHD

pix2pixHDは複数の工夫を導入することでpix2pixでは256x256の画像生成であったのを2048x1024まで精度を改善したネットワーク.ResNetを使用したこと、ネットワーク構造を多段にすること、FeatureMatchingを採用したこと、マルチスケールの対応等の工夫を入れることで実現しています.

PV 409

Fav 0

2018.07.15

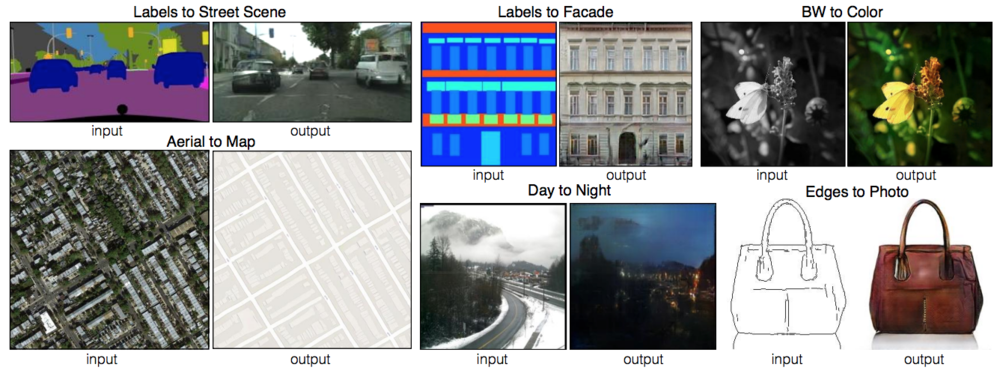

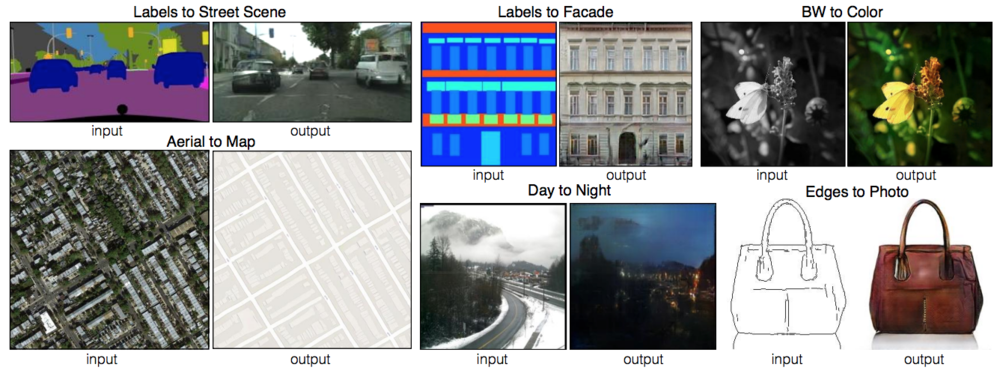

pix2pix

pix2pixはUNetとDCGANを組み合わせた汎用的な画像変換を学習することができるネットワーク.昼と夜の変換や航空写真と地図の変換等様々なタスクを行わせることができる.画像から画像の変換(Image to Image Translation)を行っているConditional GANの一種.

PV 390

Fav 0

2018.07.15

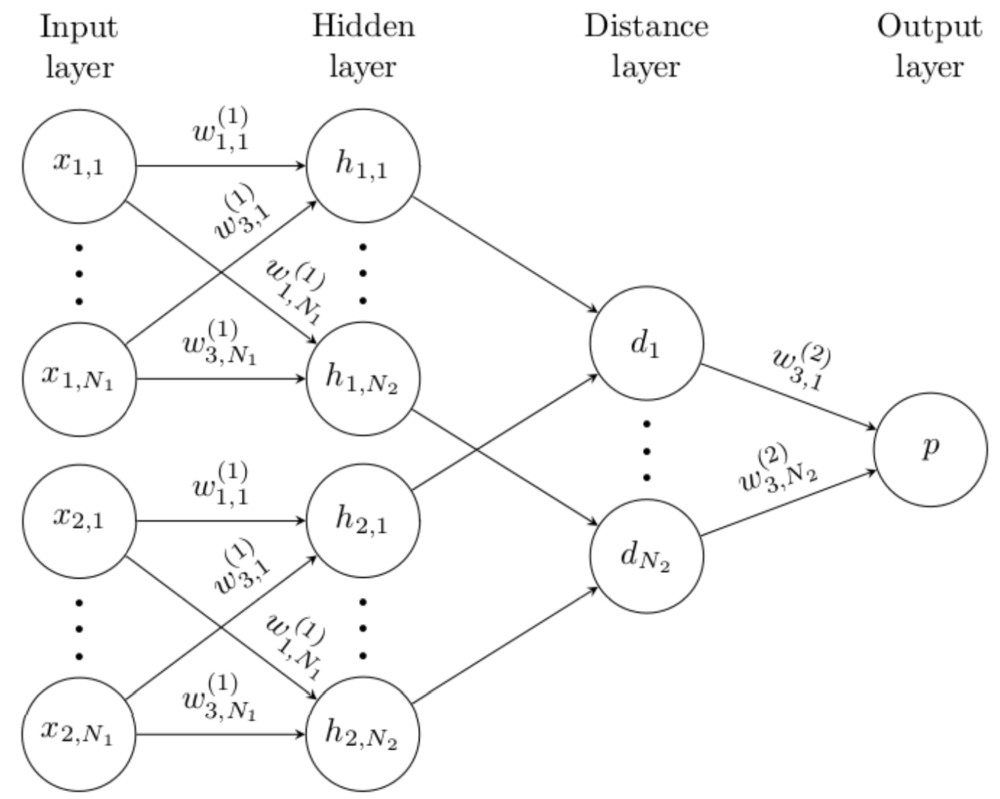

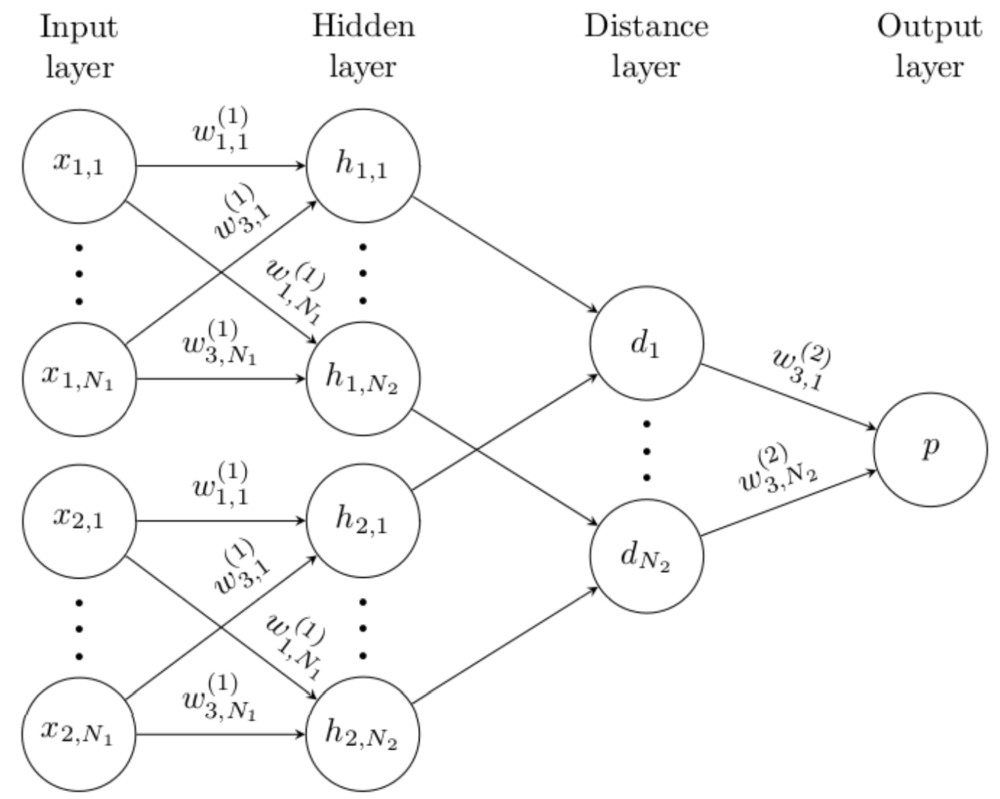

シャムネットワーク

シャムネットワークは(Siamese Network)二つの画像の似ている似ていないという指標となる距離を学習するCNNを利用したニューラルネットワーク.二つのCNNは重みが共有されていてそれらの出力を距離を計算するネットワークに入力する.

PV 725

Fav 0

2018.07.15

Perturbation層

Perturbation層(perturbationは摂動)は入力されたチャンネルにランダムに生成した固定のノイズを足し合わせ非線形変換したものを重みで足し合わせて出力する層.実際にはConvolution層のような3x3の畳み込みは行わず、画素に注目しており言わば1x1の畳み込みを行っている.

Convolution層で構成されるCNNをPerturbation層で置き換えたPNNを用いてもこれまでCNNで達成されていた性能が達成できる.

ここではPerturbation層について簡単に紹介する.

PV 208

Fav 0

2018.07.05

PGGAN

高解像度な顔画像の生成を達成したProgressive Growing of GANに関して紹介します.これまで256x256ほどのサイズだった画像生成を1024x1024の高解像度でかつ精度よく行えていることが特徴です.

PV 325

Fav 0

2018.07.05

Deconvolution はUnpoolingやUpsamplingとは違いますか?

PV 133

Fav 0

2017.09.26

Deep Learningの最適化関数選定に関して

PV 90

Fav 0

2017.09.24

機械学習のpythonライブラリお薦め

PV 101

Fav 0

2017.09.22

ニューラルネットワークの翻訳への適用のしかたが分からない

PV 118

Fav 0

2017.09.22

おすすめのDeepLearningのネットワークはどれですか?

PV 118

Fav 0

2017.09.20

DeepLearning人気知識・質問

CTC損失関数

CTC Loss(損失関数) (Connectionist Temporal Classification)は、音声認識や時系列データにおいてよく用いられる損失関数で、最終層で出力される値から正解のデータ列になりうる確率を元に計算する損失関数.LSTMやRNNなどの出力を受けて正解文字列の確率を計算する.HMMのように前向き後ろ向きアルゴリズム、動的計画法を元に計算、微分可能であり誤差逆伝播が可能.

PV 1552

Fav 0

2018.12.08

Attention機構

Attention機構(注意機構)とは、主に機械翻訳や画像処理等を目的としたEncoder-Decoderモデルに導入される要素ごとの関係性、注意箇所を学習する機構.機械翻訳において翻訳対象の単語間の関係性や全体のコンテキストを考慮させるために考案されたものだが、画像処理などにおいても応用されている.

PV 1284

Fav 0

2018.12.08

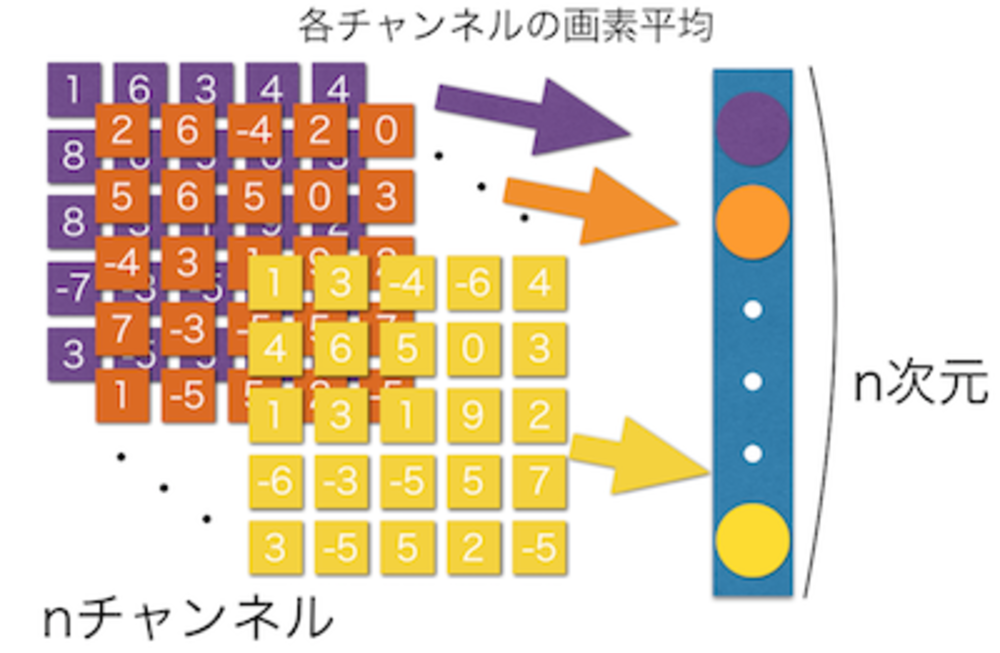

Global Average Pooling層

Global Average Pooling層によって最後の層において直接平均してクラスを作り出す。

PV 874

Fav 0

2017.09.18

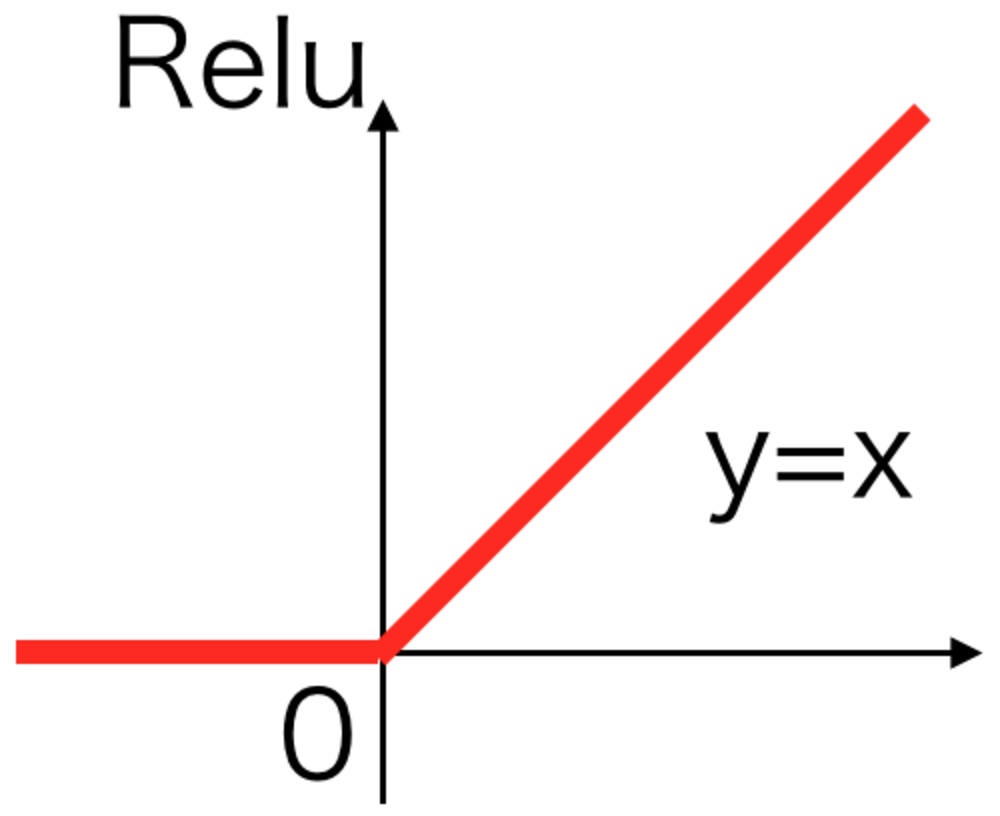

Relu活性化関数

最も現在使われることの多い活性化関数。

xが負のとき0それ以外は恒等関数.

シグモイドなどより計算が早いことが特徴.

PV 865

Fav 0

2017.09.13

シャムネットワーク

シャムネットワークは(Siamese Network)二つの画像の似ている似ていないという指標となる距離を学習するCNNを利用したニューラルネットワーク.二つのCNNは重みが共有されていてそれらの出力を距離を計算するネットワークに入力する.

PV 725

Fav 0

2018.07.15

Mode Collapseとは

Mode Collapseとは、GAN等で主に問題となる数種類の結果のみを出力するようになってしまう問題のこと.例えば1から10までの数字の画像生成をさせようと学習しても6ばかり出すようになってしまう.

PV 683

Fav 0

2018.12.04

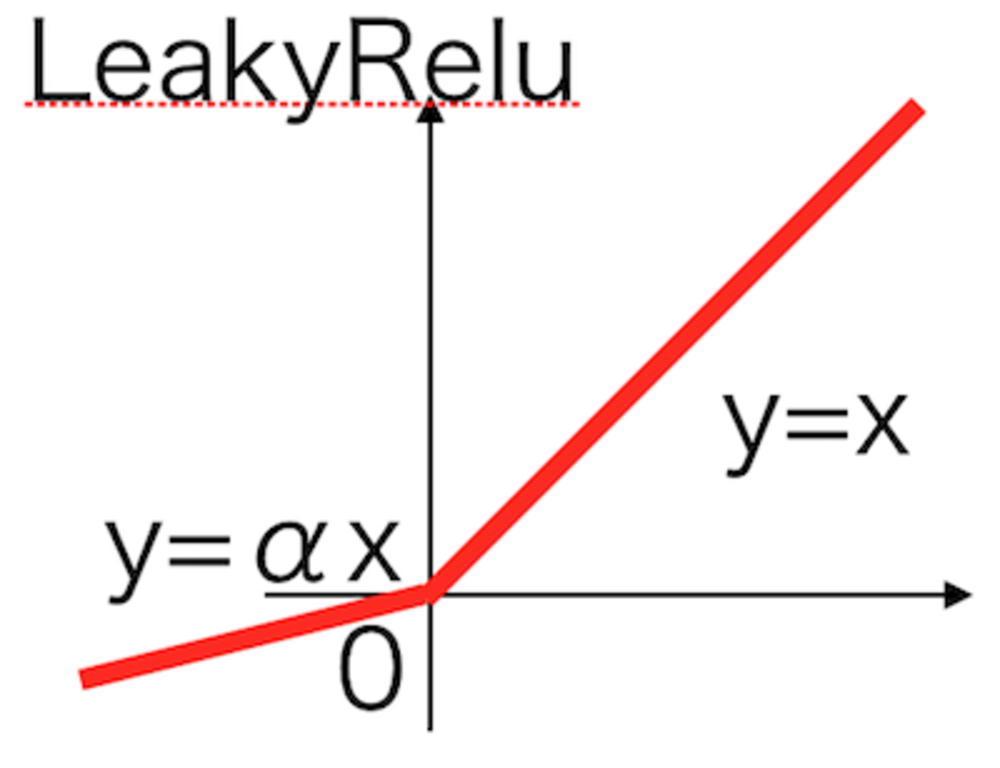

LeakyRelu活性化関数

Reluでxが負の場合を改良したLeakyRelu活性化関数.

PV 680

Fav 0

2017.09.13

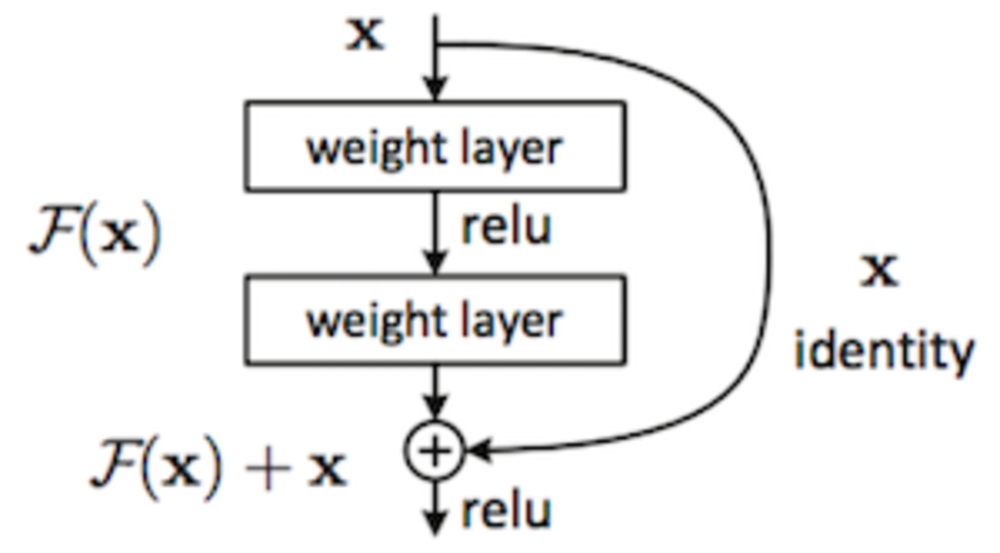

ResNetとは

ResNetは2015年にMicrosoftより発表された152層からなるニューラルネットワーク.

今まで20層ほどで作られていたCNNを特別なユニットを挟むことで深くすることを可能にした.

PV 612

Fav 0

2017.09.13

CNNで画像内文字列をOCR

CNNを使って画像の文字列を認識してプログラムで扱える文字列に起こすOCRの例について紹介します.文字列が可変の場合に対応したCNN+LSTMで構成される基本的なネットワークです.

PV 587

Fav 0

2018.12.06

Adam最適化関数

学習係数を自動で調整させる最適化関数の一つ.

Adagrad, RMSPropを改良し移動平均を付け加えた最適化関数.

PV 563

Fav 0

2017.09.13

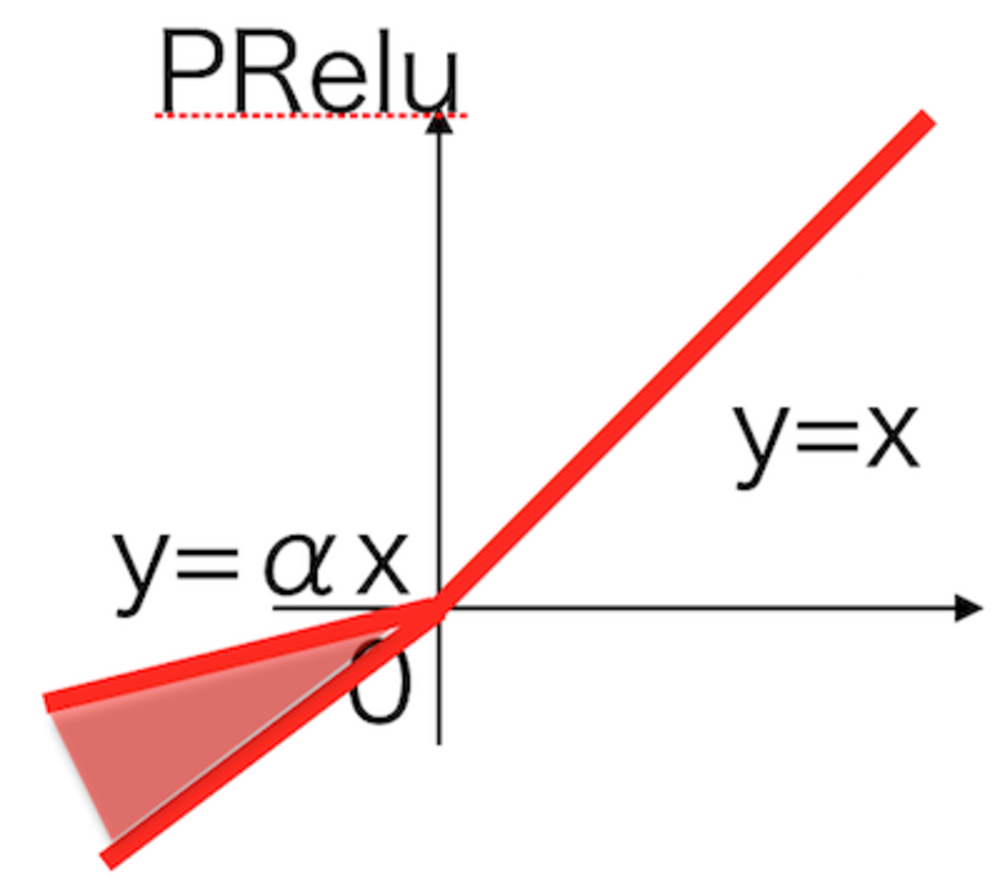

PRelu活性化関数

LeakyReluを改良して、学習しながら適切な傾きを変更していく.

PRelu活性化関数.

PV 530

Fav 0

2017.09.13

UnPooling層

Convolutional AutoEncoder(CAE)などで用いられるMaxPoolingの反対の動き(画素を拡大する)をする層

PV 455

Fav 0

2017.09.13

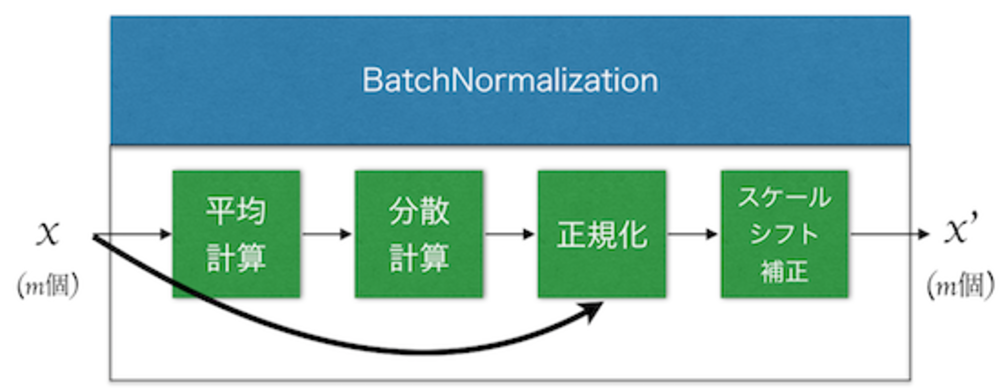

Batch Normalization層

Batch Normalization層は近年提案されるどのネットワークにも大体使用される学習を安定させ高速化させる技術. ミニバッチごとの平均と分散を計算して正規化し、スケールとシフト補正をする.

PV 440

Fav 0

2017.09.13

Adagrad最適化関数

学習係数を自動調整していく最適化関数の一つ.

過去の勾配と最新の勾配を元に各パラメータごとに学習率を調整するのが特徴.

Adam, Adadelta, RMSPropはAdagradを改良したもの

PV 435

Fav 0

2017.09.13

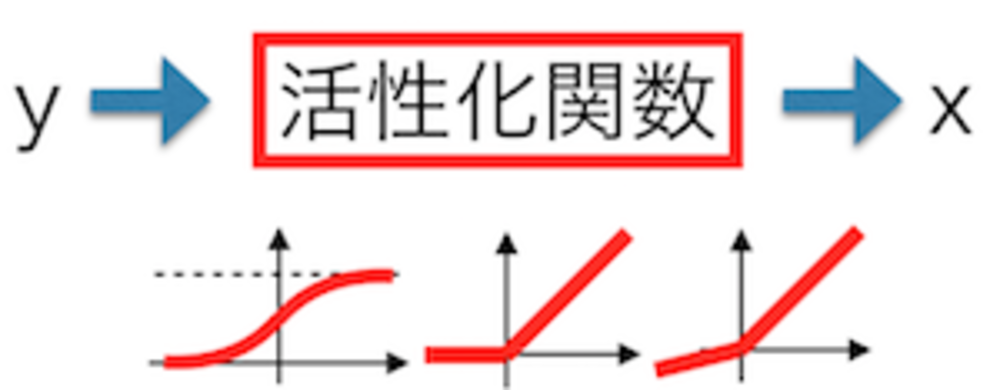

活性化関数とは

Deep Learningで層の出力の際に必ず使われる活性化関数。

活性化関数は、そのニューロンの出力を補正してやる役割があり、発散等を防いでいます。これらはネットワークの表現力を高くするために常に非線形関数が用いられます.

PV 414

Fav 0

2017.09.13

pix2pixHD

pix2pixHDは複数の工夫を導入することでpix2pixでは256x256の画像生成であったのを2048x1024まで精度を改善したネットワーク.ResNetを使用したこと、ネットワーク構造を多段にすること、FeatureMatchingを採用したこと、マルチスケールの対応等の工夫を入れることで実現しています.

PV 409

Fav 0

2018.07.15

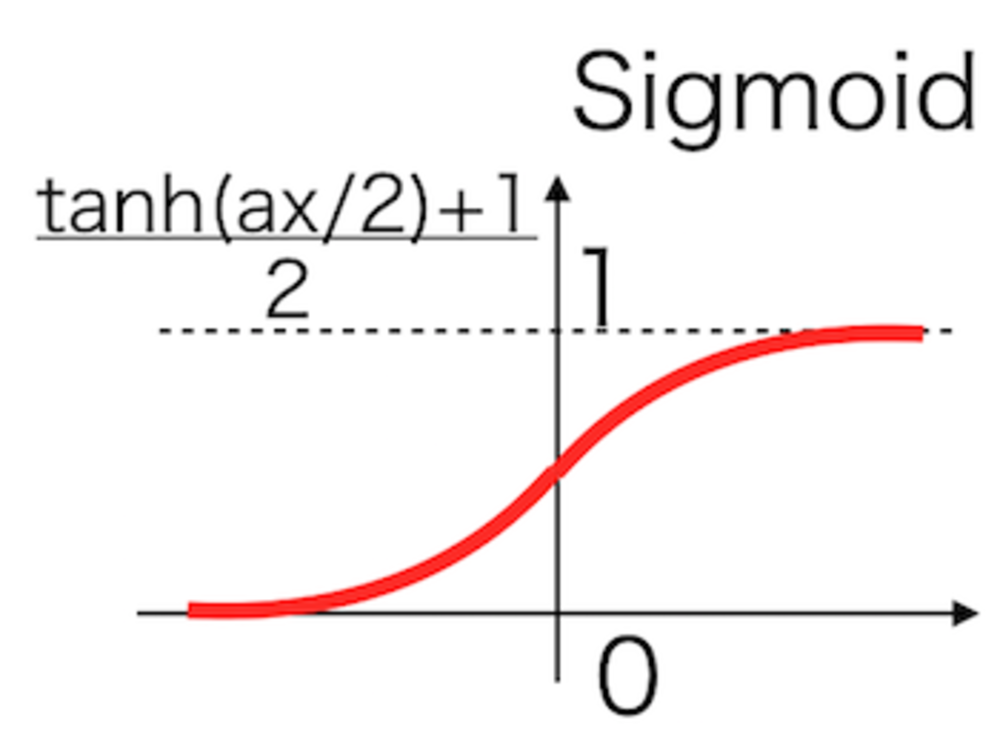

Sigmoid活性化関数

1990年代まで最も長らく使われていたニューラルネットの活性化関数.

人間のニューロンの入出力にヒントを得て設計され、微分も用意なため重宝されてきたが、勾配消失問題の原因になっているため、現在では使われない.

PV 404

Fav 0

2017.09.13

pix2pix

pix2pixはUNetとDCGANを組み合わせた汎用的な画像変換を学習することができるネットワーク.昼と夜の変換や航空写真と地図の変換等様々なタスクを行わせることができる.画像から画像の変換(Image to Image Translation)を行っているConditional GANの一種.

PV 390

Fav 0

2018.07.15

ACGAN

ACGAN(Auxiliary Classifier Generative Adversarial Network)は、DCGANではランダムノイズ列から画像を作っていただけにすぎない学習に加えて、画像のクラスラベル情報をGeneratorに入力しDiscriminatorで補助的なクラス識別タスクを行うことで、高精度な画像を生成できたネットワーク.学習は128x128の画像を入力としてImageNetの画像を使用している.

PV 389

Fav 0

2018.07.15

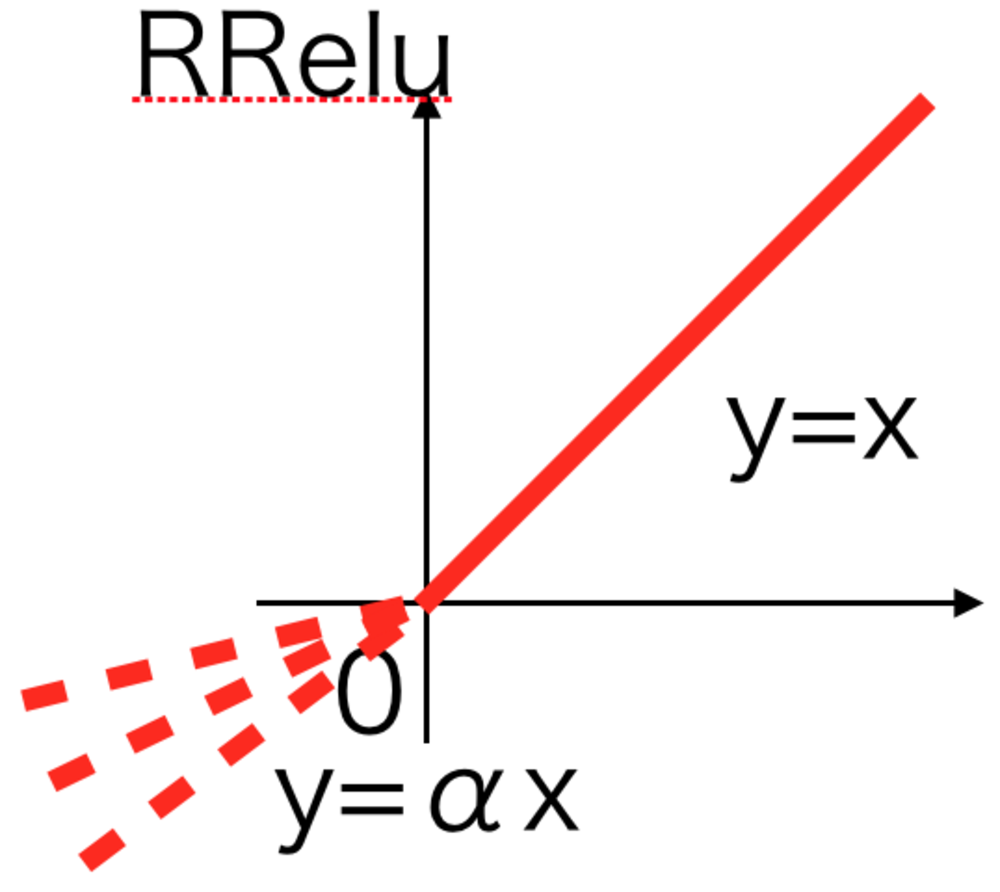

RRelu活性化関数

PReluでは傾きを学習していたが、RReluではある幅の中で傾きをランダムにしている.

Randomized Leaky Relu活性化関数と呼ばれる.

PV 386

Fav 0

2017.09.13

Deconvolution はUnpoolingやUpsamplingとは違いますか?

PV 133

Fav 0

2017.09.26

おすすめのDeepLearningのネットワークはどれですか?

PV 118

Fav 0

2017.09.20

ニューラルネットワークの翻訳への適用のしかたが分からない

PV 118

Fav 0

2017.09.22

機械学習のpythonライブラリお薦め

PV 101

Fav 0

2017.09.22

Deep Learningの最適化関数選定に関して

PV 90

Fav 0

2017.09.24